Nachtschichten für Literaturrecherchen? Haarkämpfe beim Verfassen von wissenschaftlichen Arbeiten? Keine Panik! Die wissenschaftlichen Experten von AI2 kommen mit ihrem neuesten Werk OpenScholar zu Ihrer Rettung! Dieses wissenschaftliche Effizienz-Wunderwerk macht Literaturrecherchen so einfach und angenehm wie einen Spaziergang im Park!

OpenScholars größte Geheimwaffe ist OpenScholar-Datastore (OSDS) – eine Datenbank mit 450 Millionen Open-Access-Artikeln und 237 Millionen eingebetteten Textabschnitten. Mit diesem riesigen Wissensvorrat kann OpenScholar mühelos alle Arten von wissenschaftlichen Herausforderungen meistern.

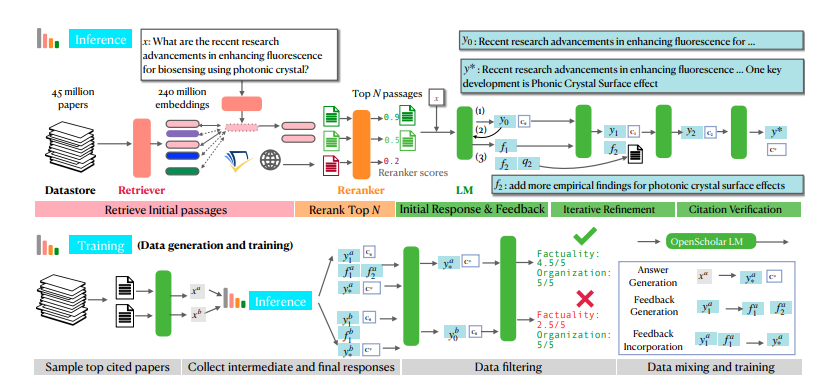

Wenn Sie auf ein wissenschaftliches Problem stoßen, setzt OpenScholar zunächst seine zuverlässigen Helfer ein – die Such- und Re-Ranking-Module. Diese filtern schnell relevante Textabschnitte aus OSDS heraus. Anschließend liefert ein Sprachmodell (LM) eine vollständige Antwort inklusive Referenzen. Noch beeindruckender ist, dass OpenScholar die Antwort kontinuierlich anhand Ihres Feedbacks verbessert und fehlende Informationen ergänzt, bis Sie zufrieden sind.

OpenScholar ist nicht nur selbst leistungsstark, sondern hilft auch bei der Ausbildung kleinerer und effizienterer Modelle. Forscher haben mit OpenScholars Prozess riesige Mengen hochwertiger Trainingsdaten generiert und damit ein 8 Milliarden Parameter umfassendes Sprachmodell namens OpenScholar-8B sowie andere Suchmodelle trainiert.

Um die Leistungsfähigkeit von OpenScholar umfassend zu testen, haben die Forscher eine neue Testumgebung namens SCHOLARQABENCH entwickelt. Diese bietet verschiedene Aufgaben zur wissenschaftlichen Literaturrecherche, darunter geschlossene Klassifizierung, Multiple-Choice-Fragen und die Generierung langer Texte. Die Aufgaben umfassen Bereiche wie Informatik, Biomedizin, Physik und Neurowissenschaften. Für Fairness und Objektivität verwendet SCHOLARQABENCH verschiedene Bewertungsmethoden, darunter Expertenbewertungen, automatische Metriken und User-Experience-Tests.

Nach mehreren intensiven Runden setzte sich OpenScholar durch! Die Ergebnisse zeigen eine hervorragende Leistung in allen Aufgaben, die sogar menschliche Experten übertrifft! Dieser bahnbrechende Erfolg wird die wissenschaftliche Forschung revolutionieren und Wissenschaftler von der mühsamen Literaturrecherche befreien, damit sie sich auf die Erforschung wissenschaftlicher Geheimnisse konzentrieren können!

Die Leistungsfähigkeit von OpenScholar beruht hauptsächlich auf seinem einzigartigen Mechanismus zur selbstregulierenden, suchbasierten Inferenz. Vereinfacht gesagt, stellt es sich selbst Fragen, verbessert seine Antworten anhand der eigenen Antworten und präsentiert Ihnen schließlich die beste Antwort. Magisch, nicht wahr?

Konkret besteht der selbstregulierende Inferenzprozess von OpenScholar aus drei Schritten: Initiale Antwortgenerierung, Feedbackgenerierung und Feedbackintegration. Zuerst generiert das Sprachmodell anhand der abgerufenen Textabschnitte eine erste Antwort. Dann kritisiert es seine eigene Antwort selbst wie ein strenger Prüfer, findet Schwachstellen und generiert natürliches Sprachfeedback, z. B. „Die Antwort enthält nur die Ergebnisse zum Frage-Antwort-Experiment. Bitte ergänzen Sie die Ergebnisse anderer Aufgabentypen.“ Schließlich ruft das Sprachmodell anhand dieses Feedbacks weitere relevante Literatur ab und integriert alle Informationen, um eine umfassendere Antwort zu erstellen.

Um kleinere, aber dennoch leistungsstarke Modelle zu trainieren, haben die Forscher mit OpenScholars selbstregulierenden Inferenzprozess auch eine große Menge an hochwertigen Trainingsdaten generiert. Sie wählten zunächst die am häufigsten zitierten Artikel aus der Datenbank aus, generierten dann anhand der Zusammenfassungen dieser Artikel Informationsanfragen und generierten schließlich mit OpenScholars Inferenzprozess hochwertige Antworten. Diese Antworten und die dabei generierten Feedback-Informationen bildeten die wertvollen Trainingsdaten. Die Forscher kombinierten diese Daten mit bestehenden allgemeinen und wissenschaftlichen Anweisungsdaten und trainierten damit ein 8 Milliarden Parameter umfassendes Sprachmodell namens OpenScholar-8B.

Um OpenScholar und ähnliche Modelle umfassender zu bewerten, haben die Forscher außerdem einen neuen Benchmark namens SCHOLARQABENCH erstellt. Dieser Benchmark enthält 2967 von Experten verfasste Fragen zur Literaturrecherche aus vier Bereichen: Informatik, Physik, Biomedizin und Neurowissenschaften. Zu jeder Frage gibt es eine von Experten verfasste ausführliche Antwort, deren Erstellung im Durchschnitt etwa eine Stunde dauert. SCHOLARQABENCH verwendet eine mehrdimensionale Bewertungsmethode, die automatische Metriken und manuelle Bewertungen kombiniert, um die Qualität der vom Modell generierten Antworten umfassender zu beurteilen.

Die Ergebnisse zeigen, dass OpenScholar auf SCHOLARQABENCH deutlich besser abschneidet als andere Modelle und in einigen Bereichen sogar menschliche Experten übertrifft! Beispielsweise ist die Genauigkeit von OpenScholar-8B im Bereich Informatik um 5 % höher als bei GPT-4o und um 7 % höher als bei PaperQA2. Die Genauigkeit der Zitate in den von OpenScholar generierten Antworten ist zudem vergleichbar mit der von menschlichen Experten, während GPT-4o eine Rate von 78-90 % frei erfundener Informationen aufweist.

OpenScholar ist zweifellos ein großer Fortschritt für die wissenschaftliche Forschung! Es spart Forschern nicht nur viel Zeit und Mühe, sondern verbessert auch die Qualität und Effizienz von Literaturrecherchen. In naher Zukunft wird OpenScholar mit Sicherheit ein unverzichtbarer Helfer für Wissenschaftler sein!

论文地址:https://arxiv.org/pdf/2411.14199

项目地址:https://github.com/AkariAsai/OpenScholar