Recentemente, a Alibaba Cloud lançou o modelo de linguagem grande Qwen2-Math, uma nova estrela da IA focada em matemática que imediatamente chamou a atenção da indústria.

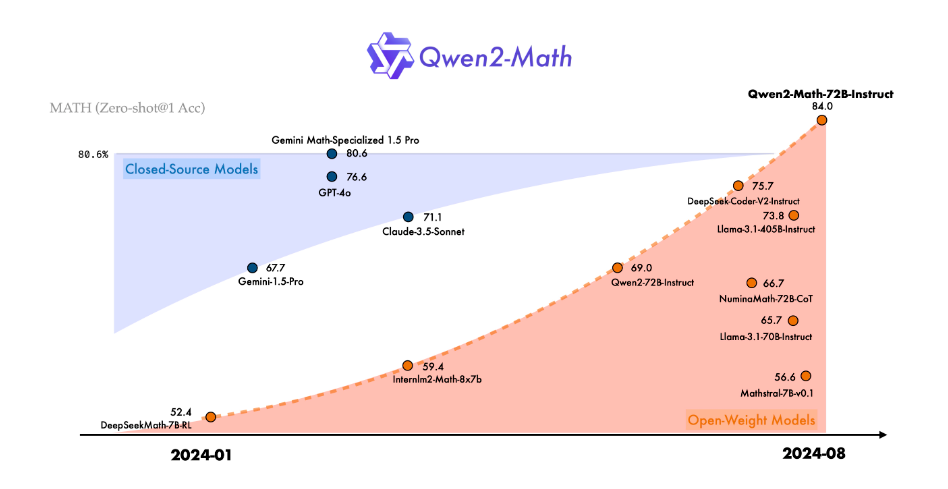

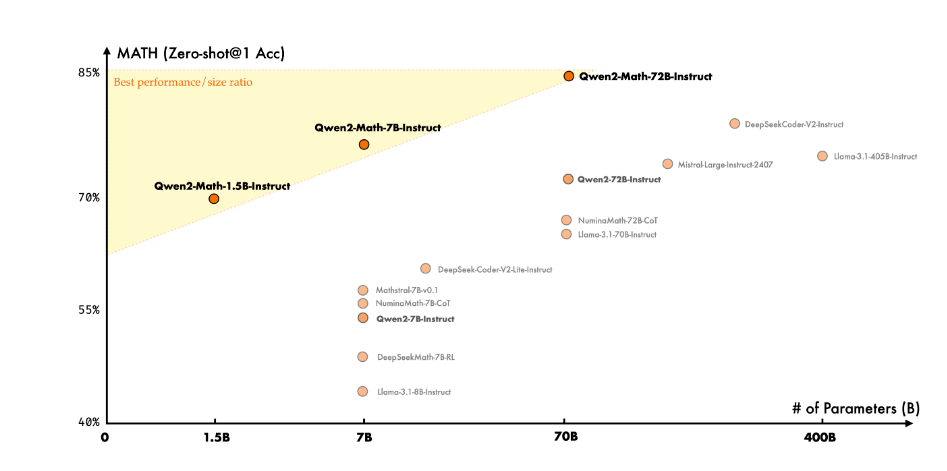

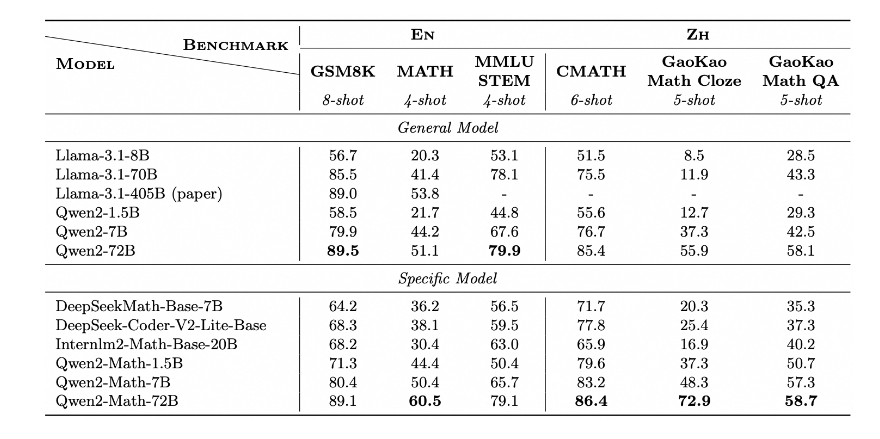

Como o mais novo membro da série Qwen2, os modelos Qwen2-Math e Qwen2-Math-Instruct-1.5B/7B/72B demonstraram uma impressionante capacidade de resolução de problemas matemáticos. Relatos indicam que esta série de modelos não apenas superou modelos de código aberto existentes em vários testes de benchmark matemáticos, mas também superou, em alguns aspectos, modelos de código fechado conhecidos, incluindo GPT-4o, Claude-3.5-Sonnet, Gemini-1.5-Pro e Llama-3.1-405B, tornando-se um verdadeiro "cavalo escuro" no mundo da matemática da IA.

O sucesso do Qwen2-Math não é coincidência. A equipe da Alibaba Cloud dedicou muito esforço no último ano para melhorar a capacidade de raciocínio de modelos de linguagem grandes em aritmética e problemas matemáticos. Esta série de modelos é baseada em Qwen2-1.5B/7B/72B, e a equipe de desenvolvimento, a partir desta base, utilizou um corpus matemático especialmente projetado para pré-treinamento profundo. Este corpus exclusivo abrange uma grande quantidade de textos matemáticos de alta qualidade da internet, livros especializados, exemplos de código e uma grande quantidade de questões de exames, incluindo até mesmo dados de pré-treinamento matemático gerados pelo próprio Qwen2.

Vale destacar o modelo Qwen2-Math-Instruct. Este modelo de recompensa especializado em matemática, treinado com base no Qwen2-Math-72B, utiliza um método de treinamento inovador. A equipe de desenvolvimento combinou inteligentemente sinais de recompensa densos e sinais binários de acerto ou erro da resposta do modelo, utilizando esta combinação como sinal de supervisão, construindo dados SFT (Supervised Fine-Tuning) através de amostragem de rejeição e aplicando a técnica de otimização de política relativa de grupo (GRPO) no aprendizado por reforço após o SFT. Este método de treinamento único melhorou significativamente a capacidade do modelo de resolver problemas matemáticos.

Em aplicações práticas, o Qwen2-Math-Instruct apresentou um desempenho impressionante. Tanto na AIME (American Invitational Mathematics Examination) de 2024 quanto na AMC (American Mathematics Competition) de 2023, o modelo apresentou excelentes resultados em várias configurações, incluindo estratégias como busca gananciosa (Greedy), votação majoritária e minimização de risco.

Ainda mais emocionante é que o Qwen2-Math também demonstrou uma boa capacidade em resolver alguns problemas difíceis do nível da Olimpíada Internacional de Matemática (IMO). Através da análise de uma série de casos de teste, os pesquisadores descobriram que o Qwen2-Math não apenas consegue lidar facilmente com problemas simples de competições matemáticas, mas também consegue fornecer soluções convincentes para problemas complexos.

No entanto, a equipe da Alibaba Cloud não parou por aí. Eles revelaram que a série atual do Qwen2-Math suporta apenas inglês, mas estão ativamente desenvolvendo um modelo bilíngue que suporta inglês e chinês, e planejam lançar uma versão multilíngue em breve. Além disso, a equipe está continuamente otimizando o modelo para melhorar ainda mais sua capacidade de resolver problemas matemáticos mais complexos e desafiadores.

O surgimento do Qwen2-Math abriu novas possibilidades para a aplicação da IA na área da matemática. Ele não apenas trará mudanças revolucionárias para o setor educacional, ajudando os alunos a entender e dominar melhor o conhecimento matemático, mas também pode desempenhar um papel importante em pesquisa científica, engenharia e outras áreas que exigem cálculos matemáticos complexos.

Página do projeto: https://top.aibase.com/tool/qwen2-math

Download do modelo: https://huggingface.co/Qwen