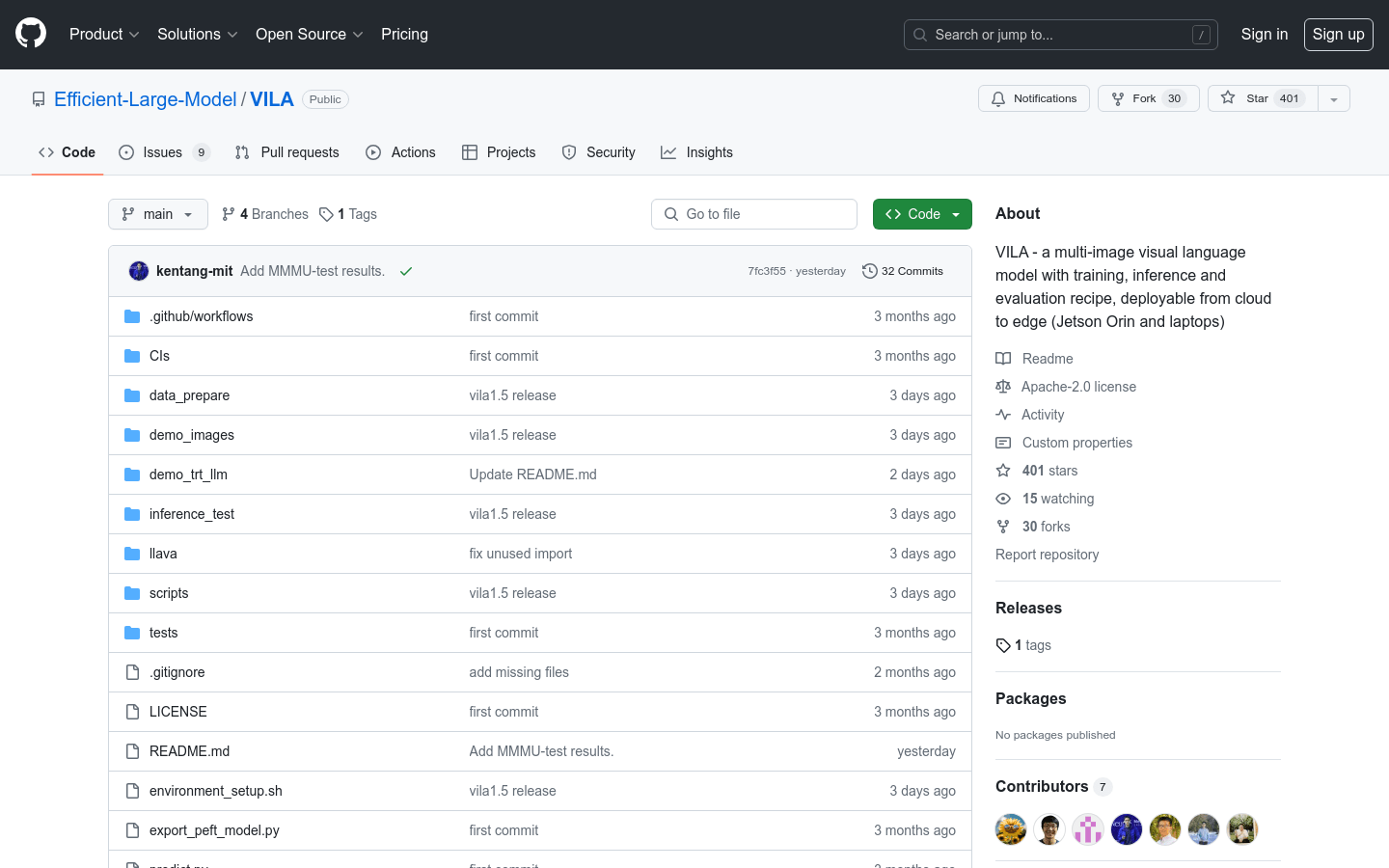

VILA

複数の画像を扱うビジョン言語モデル。トレーニング、推論、評価のためのソリューションを提供し、クラウドからエッジデバイス(Jetson Orinやノートパソコンなど)への展開が可能です。

一般製品画像ビジョン言語モデル動画理解

VILAは、大規模なインターリーブされた画像テキストデータで事前トレーニングされた、事前学習済みのビジョン言語モデル(VLM)です。これにより、動画の理解と複数の画像の理解が可能になります。VILAは、AWQ 4bit量子化とTinyChatフレームワークにより、エッジデバイスへの展開が可能です。主な利点としては、1) 性能向上に不可欠なインターリーブされた画像テキストデータ、2) コンテキスト学習を促進する、大規模言語モデル(LLM)をインターリーブされた画像テキスト事前トレーニング中に固定しないこと、3) VLMと純粋なテキストの性能を大幅に向上させるテキスト指示データのリミックス、4) 動画フレーム数の拡張を可能にするトークン圧縮、などが挙げられます。VILAは、動画推論、コンテキスト学習、ビジュアル思考連鎖、より優れた世界知識など、魅力的な能力を示します。

VILA 最新のトラフィック状況

月間総訪問数

474564576

直帰率

36.20%

平均ページ/訪問

6.1

平均訪問時間

00:06:34