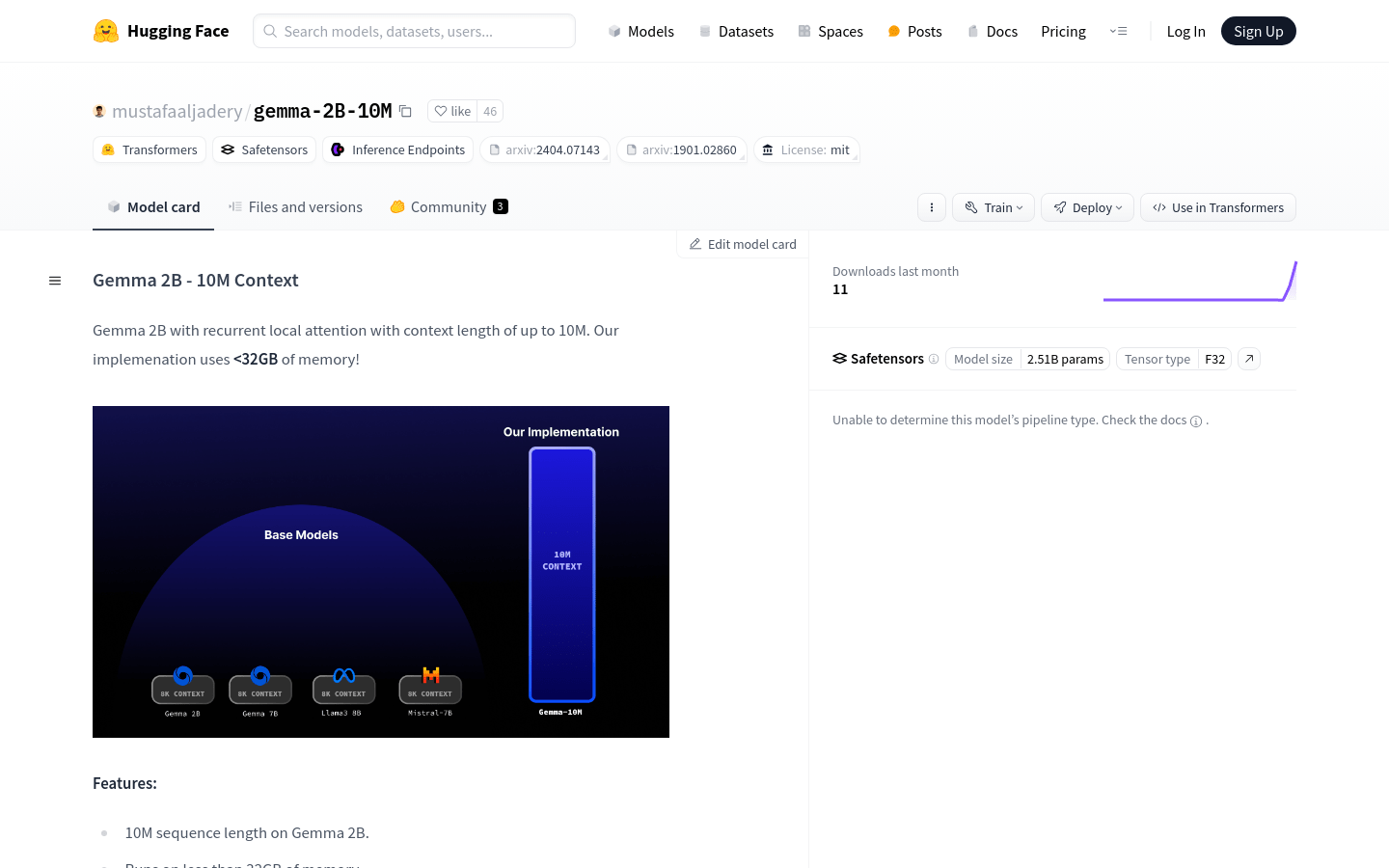

Gemma-2B-10M

Gemma 2Bモデル。最大10Mトークンのシーケンス長に対応し、メモリ使用量を最適化。大規模言語モデルアプリケーションに最適です。

一般製品プログラミング言語モデルアテンション機構

Gemma 2B - 10M Contextは、革新的なアテンション機構の最適化により、32GB未満のメモリで最大10Mトークンのシーケンスを処理できる大規模言語モデルです。Transformer-XL論文に着想を得た循環局所アテンション技術を採用し、大規模言語タスク処理のための強力なツールです。

Gemma-2B-10M 最新のトラフィック状況

月間総訪問数

29742941

直帰率

44.20%

平均ページ/訪問

5.9

平均訪問時間

00:04:44