Selon les données d'Artificial Analysis, un organisme tiers d'évaluation de l'IA, l'évaluation du modèle de raisonnement o1 d'OpenAI sur sept benchmarks populaires coûte 2 767,05 dollars, tandis que son modèle non-raisonnement GPT-4o ne coûte que 108,85 dollars. Cette différence significative a suscité un débat sur la durabilité et la transparence de l'évaluation de l'IA.

Les modèles de raisonnement, c'est-à-dire les systèmes d'IA capables de « penser » progressivement à la solution d'un problème, bien qu'excellents dans des domaines spécifiques, ont un coût d'évaluation de référence bien supérieur à celui des modèles traditionnels. Artificial Analysis estime qu'une douzaine de modèles de raisonnement ont coûté au total 5 200 dollars, soit près du double du coût de l'analyse de plus de 80 modèles non-raisonnement (2 400 dollars).

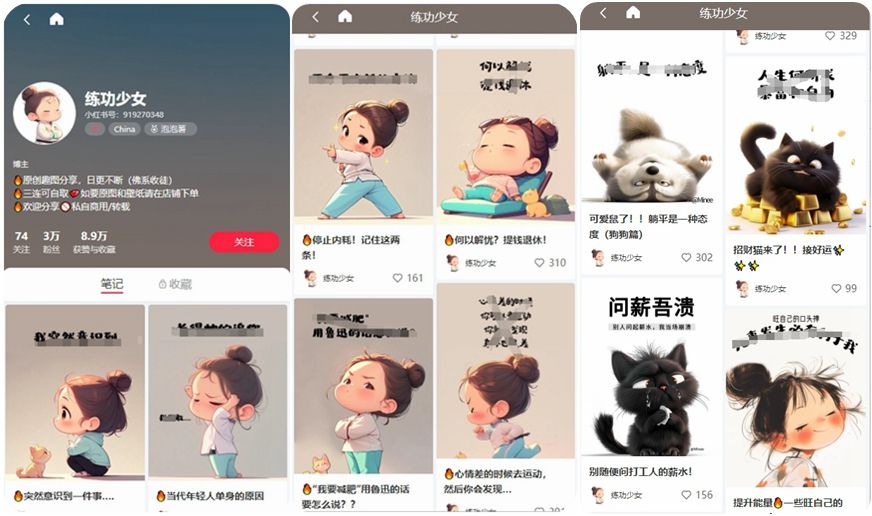

Source : Image générée par IA, fournisseur de services d'autorisation d'images : Midjourney

La différence de coût provient principalement de la grande quantité de jetons générés par les modèles de raisonnement. Par exemple, o1 a généré plus de 44 millions de jetons lors des tests, soit environ huit fois plus que GPT-4o. Avec des benchmarks de plus en plus complexes, capables d'évaluer les capacités pour des tâches du monde réel, et la hausse du coût par jeton des modèles haut de gamme (par exemple, o1-pro d'OpenAI facture 600 dollars par million de jetons de sortie), la validation indépendante des performances de ces modèles devient extrêmement coûteuse.

Bien que certains laboratoires d'IA fournissent un accès gratuit ou subventionné aux organismes de référence, les experts craignent que cela puisse nuire à l'objectivité de l'évaluation. Ross Taylor, PDG de General Reasoning, s'interroge : « D'un point de vue scientifique, si vous publiez un résultat que personne ne peut reproduire avec le même modèle, peut-on encore parler de science ? »