皆さん「ネットサーフィン達人」の皆さん、あの頃ハマっていた絵文字は覚えていますか?「地下鉄のおじさんがスマホを見ている」から「金館長パンダヘッド」まで、それらは私たちの笑いのツボをくすぐるだけでなく、独特のネットカルチャーの象徴にもなりました。今では、短編動画が世界中で流行し、絵文字も「時代に合わせて進化」し、静止画から動画へと進化し、様々なプラットフォームで爆発的な人気を博しています。

しかし、高品質な絵文字動画を作るのは簡単なことではありません。まず、絵文字の特徴は表情が誇張されていて、動作の幅が大きいことです。これは動画生成技術に大きな課題を突きつけます。次に、既存の方法の多くはモデル全体のパラメータを最適化する必要があり、これは時間と労力を費やすだけでなく、モデルの汎化能力の低下につながり、他の派生モデルとの互換性が低くなる可能性があります。「一石を投じて波紋を広げる」ようなものです。

では、生動的で面白く、高精細な絵文字動画を簡単に作成する方法はあるのでしょうか?答えは:もちろんあります!HelloMemeがあなたを救います!

HelloMemeは大規模モデルに「プラグイン」を取り付けるようなツールで、元のモデルを変更することなく、絵文字動画の作成という「新しいスキル」をモデルに学習させることができます。その秘密兵器は、二次元特徴マップに関連するアテンションメカニズムを最適化することで、アダプターのパフォーマンスを向上させることです。簡単に言えば、モデルに「透視眼鏡」をかけることで、表情や動作の細部をより正確に捉えることができるようになります。

HelloMemeの動作原理も興味深いものです。それは3人の仲間で構成されています:HMReferenceNet、HMControlNet、HMDenoisingNet。

HMReferenceNetは「数多くの作品を見てきた」熟練の職人です。参照画像から高精細な特徴を抽出することができます。これはモデルに「絵文字作成ガイド」を提供するようなもので、どんな表情が「面白い」のかを知ることができます。

HMControlNetは「モーションキャプチャマスター」のようなものです。頭部の姿勢と表情情報を抽出することができます。これはモデルに「モーションキャプチャシステム」をインストールするようなもので、細かな表情の変化を正確に捉えることができます。

HMDenoisingNetは「動画編集者」です。前の2人の仲間が提供した情報を統合して、最終的な絵文字動画を生成します。経験豊富な編集者のように、様々な素材を完璧に融合させ、腹を抱えて笑える動画作品を作り出します。

この3人の仲間がより良く協力できるように、HelloMemeは「空間織りアテンションメカニズム」という魔法を使っています。このメカニズムはセーターを編むようなもので、異なる特徴情報を織り交ぜることで、二次元特徴マップの構造情報を保持します。これにより、モデルはこれらの基礎知識を再学習する必要がなくなり、絵文字作成の「芸術的創作」に集中することができます。

HelloMemeの最も優れた点は、トレーニング中にSD1.5UNetモデルの元の参数を完全に保持し、挿入アダプターのパラメータのみを最適化していることです。**これはモデルに「パッチを当てる」ようなもので、モデルに「大手術」を行うようなものではありません。**このようにすることで、元のモデルの強力な機能を維持しながら、新しい機能も付加することができ、一石二鳥です。

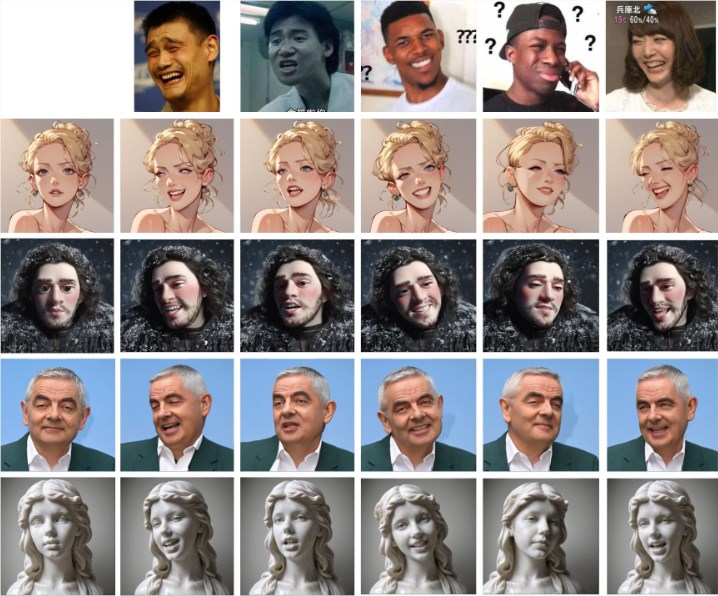

HelloMemeは絵文字動画生成タスクで非常に優れた成果を上げています。生成された動画は表情が生き生きとしていて、動作がスムーズで、画質も高く、プロレベルの制作水準に匹敵します。さらに重要なのは、HelloMemeがSD1.5派生モデルと良好な互換性を持っていることです。これは、他のモデルの長所を利用して、絵文字動画の品質をさらに向上させることができることを意味します。

もちろん、HelloMemeにはまだ改善の余地がたくさんあります。例えば、生成された動画はフレームの連続性において、GANベースの方法にやや劣り、スタイル表現能力も向上させる必要があります。しかし、HelloMemeの研究チームは、モデルをさらに強化し、「面白い」ものにするために努力を続けると述べています。

近い将来、HelloMemeが絵文字動画作成の最適なツールとなり、私たちの「面白い」発想を自由に解き放ち、絵文字で短編動画時代を支配することを願っています!

プロジェクトアドレス:https://songkey.github.io/hellomeme/