Recentemente, pesquisadores da Universidade Cornell e outras instituições realizaram um teste de referência de alucinações em vários modelos de IA generativa, incluindo GPT-4o, Claude e Gemini. A pesquisa descobriu que mesmo os modelos mais avançados só geram texto sem alucinações cerca de 35% das vezes, indicando que a confiabilidade da IA ainda precisa melhorar.

Os pesquisadores projetaram um conjunto de perguntas que incluíam conteúdo não coberto pela Wikipédia, verificando os fatos por meio de fontes autorizadas em temas como direito, saúde e história. Os resultados mostraram que os modelos da OpenAI tiveram o melhor desempenho geral, mas com progresso limitado em comparação com a versão anterior do GPT-3.5. Curiosamente, o tamanho do modelo não determinou a frequência de alucinações; modelos menores, como o Claude3Haiku, tiveram desempenho comparável a modelos maiores.

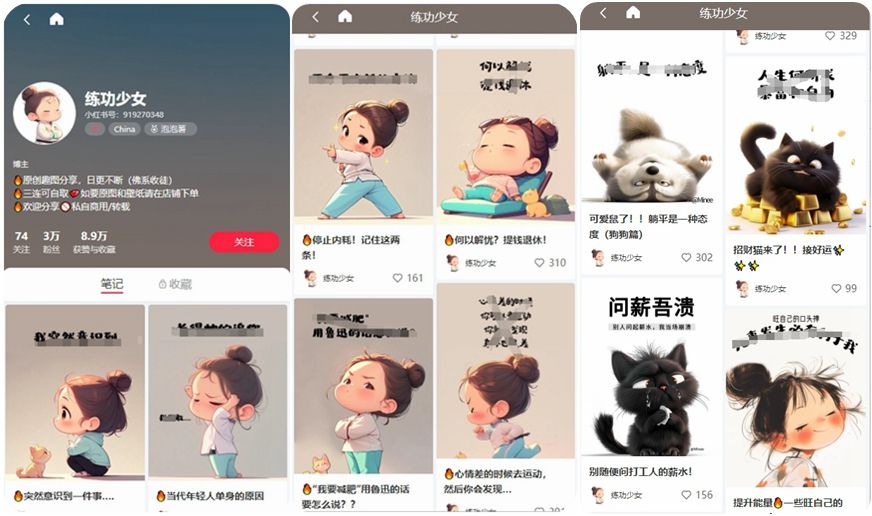

Nota da imagem: Imagem gerada por IA, serviço de licenciamento de imagens Midjourney

Zhao Wenting, coautora do estudo, apontou que mesmo modelos capazes de pesquisar online têm dificuldade em resolver problemas "não-Wikipédia", refletindo a profunda influência da Wikipédia nos modelos. Ela prevê que o problema das alucinações persistirá "por muito tempo", em parte porque os próprios dados de treinamento podem conter informações incorretas.

Uma solução temporária é aumentar a frequência com que os modelos se recusam a responder. O Claude3Haiku, respondendo apenas 72% das perguntas, tornou-se o modelo mais "honesto". No entanto, essa estratégia pode afetar a experiência do usuário.

Zhao sugere que eliminar completamente as alucinações pode não ser realista, mas o problema pode ser atenuado por meio de verificação de fatos humana, fornecimento de referências, etc. Ela defende a criação de políticas que garantam a participação de especialistas humanos na verificação de informações geradas por IA.