De acordo com dados da Artificial Analysis, uma agência de testes de IA independente, a avaliação do modelo de raciocínio o1 da OpenAI em sete benchmarks populares custou US$ 2.767,05, enquanto seu modelo não-raciocínio GPT-4o custou apenas US$ 108,85. Essa diferença significativa gerou debates sobre a sustentabilidade e a transparência da avaliação de IA.

Modelos de raciocínio, ou seja, sistemas de IA capazes de "pensar" passo a passo na solução de problemas, embora se destaquem em áreas específicas, têm custos de benchmark muito mais altos do que os modelos tradicionais. A Artificial Analysis avaliou cerca de uma dúzia de modelos de raciocínio, com um custo total de cerca de US$ 5.200, quase o dobro do custo de análise de mais de 80 modelos não-raciocínio (US$ 2.400).

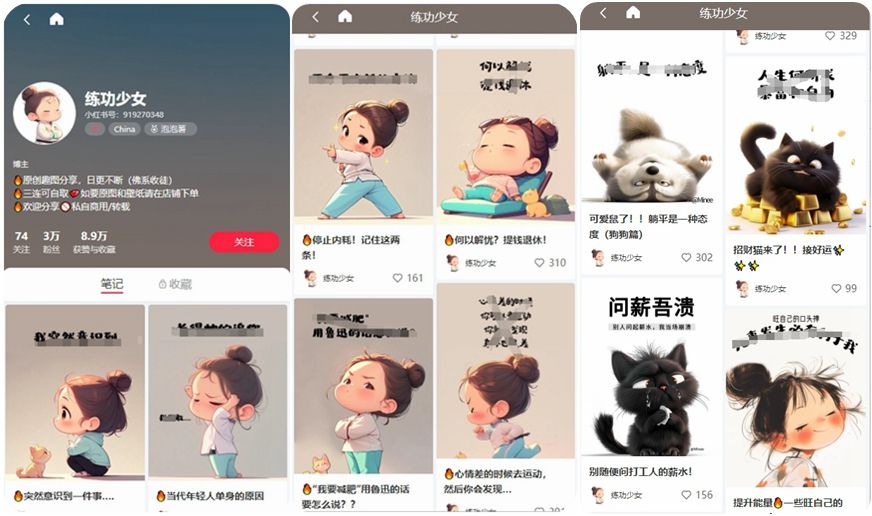

Nota da fonte: Imagem gerada por IA, fornecida pela Midjourney.

A diferença de custo é principalmente devido à grande quantidade de tokens gerados pelos modelos de raciocínio. Por exemplo, o o1 gerou mais de 44 milhões de tokens nos testes, cerca de oito vezes mais que o GPT-4o. À medida que os benchmarks se tornam mais complexos, avaliando a capacidade de realizar tarefas do mundo real, juntamente com o aumento do custo por token dos modelos top de linha (como o o1-pro da OpenAI, que cobra US$ 600 por milhão de tokens de saída), a verificação independente do desempenho desses modelos torna-se extremamente cara.

Embora alguns laboratórios de IA forneçam acesso gratuito ou subsidiado a agências de benchmark, especialistas temem que isso possa prejudicar a objetividade da avaliação. Ross Taylor, CEO da General Reasoning, questiona: "Do ponto de vista científico, se você publica um resultado que ninguém pode replicar usando o mesmo modelo, ainda pode ser considerado ciência?"