清华团队领衔打造,首个 AI agent 系统性基准测试问世

学生头条

本文来自AIbase日报

欢迎来到【AI日报】栏目!这里是你每天探索人工智能世界的指南,每天我们为你呈现AI领域的热点内容,聚焦开发者,助你洞悉技术趋势、了解创新AI产品应用。

欢迎来到【AI日报】栏目!这里是你每天探索人工智能世界的指南,每天我们为你呈现AI领域的热点内容,聚焦开发者,助你洞悉技术趋势、了解创新AI产品应用。

OpenAI 团队推出了一个名为 PaperBench 的基准测试,旨在评估AI代理在复制先进 AI 研究方面的能力。该测试要求 AI 代理从头开始复制20篇2024年国际机器学习会议(ICML)中的重点和口头论文,整个过程涉及理解论文贡献、开发代码库以及成功执行实验。为确保评估的客观性,研究人员设计了详细的评分标准。这些标准将每项复制任务分解为多个层级的子任务,并设定明确的评分标准。PaperBench 一共包含8316个可以单独评分的任务,所有评分量规均与每篇论文的作者合作开发,以保证其准确性和真

近日,清华大学的研究团队开源了其最新的研究成果——Video-T1。这项技术的核心在于测试时缩放 (Test-Time Scaling, TTS),旨在通过在视频生成过程的推理阶段投入更多的计算资源,显著提升生成视频的质量和与文本提示的一致性,而无需重新进行昂贵的模型训练。这一创新性的方法为视频生成领域带来了新的可能性。何为“测试时缩放”?在大型语言模型 (LLMs) 领域,研究人员已经发现,通过在测试阶段增加计算量可以有效提升模型性能。Video-T1借鉴了这一思路,并将其应用于视频生成

腾讯近日宣布推出其最新的大型语言模型——混元-T1,并表示该模型在推理能力上可与OpenAI的最佳推理系统相匹敌。据腾讯介绍,混元-T1在开发过程中高度依赖强化学习,高达96.7%的训练后算力都用于提升模型的逻辑推理能力以及与人类偏好的一致性。在多项基准测试中,混元-T1展现出强大的性能。在测试14个学科知识的MMLU-PRO评估中,该模型取得了87.2分,仅略低于OpenAI的o1模型。在科学推理方面,浑元-T1在GPQA-diamond测试中获得了69.3分。尤其值得一提的是,腾讯强调混元-T1在数学方面的卓越

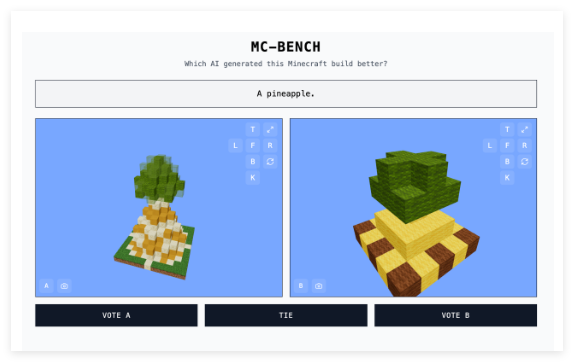

在人工智能技术飞速发展的今天,如何有效地评估和比较不同生成式AI模型的实力,成为了一个备受关注的难题。传统的AI基准测试方法逐渐显露出其局限性,为此,AI开发者们正积极探索更具创新性的评估途径。近日,一款名为“Minecraft Benchmark”(简称MC-Bench)的网站横空出世,其独特之处在于,它利用微软旗下的沙盒建造游戏《我的世界》(Minecraft)作为平台,让用户通过对比AI模型根据提示所创建的游戏作品,来评估它们的表现。而令人惊讶的是,这个新颖平台的创建者,竟然是一位年仅

一位12年级学生建立了一个创新平台,让人们能够评估不同AI模型在Minecraft创作中的表现,为人工智能评测领域带来了新的视角。新基准测试方法应对传统评估局限性随着传统AI基准测试方法的局限性日益明显,开发者们开始寻找更具创造性的评估途径。对一群开发者而言,微软旗下的沙盒建造游戏Minecraft成为了理想选择。高中生Adi Singh与团队合作开发的Minecraft Benchmark(简称MC-Bench)网站允许AI模型在面对面的挑战中相互竞争,通过Minecraft创作来回应各种提示。用户可以投票选出表现更佳的

AI 智能体工具 Manus 宣布与阿里通义千问达成战略合作,计划推出其中文版。这一合作将基于阿里通义千问的开源模型,在国产算力平台上实现 Manus 的全部功能,旨在为中文用户提供更为便捷和高效的 AI 应用体验。Manus 是由创业公司 Monica.im 孵化的项目,该公司成立于2023年7月,致力于开发面向消费者的 AI 工具和浏览器插件。创始团队包括了经验丰富的连续创业者肖弘和季逸超,以及曾在字节跳动负责产品的张涛。自推出以来,Manus 因其创新的智能体功能而引起了广泛关注。图源备注:图

受够了那些只会 纸上谈兵 的 AI 助手,问啥答啥,但干活还得靠自己? 准备迎接 AI 界的 真·干将 —— Manus! 这款横空出世的 AI 智能体, 彻底颠覆了我们对 AI 的固有印象: 它不再只是一个 问答机器人, 而是一个 真正能帮你完成任务的 超级打工人! Manus 不仅能 理解 你的需求, 更能 分析 问题, 自动执行 任务, 最终 直接交付 可食用 的最终结果! 这简直是 AI 界的一股 清流, 让效率提升不再是 空谈!Manus 究竟有多 能打? 简单来说, 它就像一个 全能型选手, 不仅 脑力惊人, 还能 手脚麻利

最近,来自全球知名动态基准测试平台 LiveCodeBench 的信息显示,Kimi 最新发布的 k1.6模型在编程能力方面表现卓越,已经超越了 OpenAI 的 GPT-3(包括 o3mini 和 o1等版本),登上了性能排行榜的第一名。这一消息无疑为科技界带来了激动与期待。据月之暗面的研究员 Flood 透露,k1.6是在 k1.5的基础上进行训练和优化的,目前其性能仍在不断提升中。月之暗面的联合创始人张予彤在社交平台上也分享了这一喜讯,他表示:“虽然 k1.6还没有正式发布,但看到 LiveCodeBench 的测试成绩,感到非常开心,期

近期,关于人工智能基准测试的争论在公众视野中愈演愈烈。OpenAI 的一名员工指责马斯克创办的 AI 公司 xAI 发布了误导性的 Grok3基准测试结果,而 xAI 的联合创始人伊戈尔・巴布申金则坚称公司没有问题。事件的起因是 xAI 在其博客上发布了一张图表,展示了 Grok3在 AIME2025测试中的表现。AIME2025是最近一场数学邀请赛中的一系列挑战性数学问题的集合。虽然一些专家对 AIME 作为 AI 基准的有效性表示怀疑,但它仍然被广泛用来评估模型的数学能力。xAI 的图表显示,Grok3的两个变体 ——Grok3Rea

OpenAI近日发布了一项重要的AI编程能力评估报告,通过价值100万美元的实际开发项目揭示了AI在软件开发领域的现状。这项名为SWE-Lancer的基准测试涵盖了1,400个来自Upwork的真实项目,全面评估AI在直接开发和项目管理两大领域的表现。测试结果显示,表现最佳的AI模型Claude3.5Sonnet在编码任务中的成功率为26.2%,在项目管理决策方面达到44.9%。虽然这一成绩与人类开发者仍有差距,但在经济效益方面已展现出可观潜力。数据显示,仅在公开的Diamond数据集中,该模型就能完成价值208,050美元的项