谷歌MobileDiffusion实现手机0.2秒文生成图,创移动端速度新纪录

机器之心

本文来自AIbase日报

欢迎来到【AI日报】栏目!这里是你每天探索人工智能世界的指南,每天我们为你呈现AI领域的热点内容,聚焦开发者,助你洞悉技术趋势、了解创新AI产品应用。

欢迎来到【AI日报】栏目!这里是你每天探索人工智能世界的指南,每天我们为你呈现AI领域的热点内容,聚焦开发者,助你洞悉技术趋势、了解创新AI产品应用。

在人工智能视频生成领域,扩散模型以其卓越的性能备受瞩目。然而,其固有的迭代去噪特性导致生成过程耗时且计算成本高昂,成为制约其广泛应用的关键瓶颈。近日,来自B北京航空大学、香港大学和上海人工智能实验室的研究团队联合发布了一项名为 AccVideo 的创新技术。该方法通过一种新颖高效的蒸馏方法,并结合合成数据集,成功将视频扩散模型的生成速度提升了惊人的8.5倍。现有的视频扩散模型在生成高质量视频方面表现出色,但其迭代式的去噪过程需要大量的推理步骤。这意

2025年3月10日,一项名为 TrajectoryCrafter 的前沿技术正式亮相,引发了科技界和视频创作领域的广泛关注。这项基于扩散模型(diffusion models)的创新技术,能够从单一视角的单目视频中推断并生成全新的视角,为视频后期制作带来了革命性的可能性。TrajectoryCrafter 的核心在于其强大的视角重定向能力。传统的单目视频受限于单一相机视角,创作者往往无法在后期调整拍摄角度或运镜方式。而 TrajectoryCrafter 通过扩散模型的深度学习技术,能够分析视频内容并推演出三维空间信息,从而允许用户

近日,开发者 scraed 在 GitHub 上发布了 LanPaint,一个无需额外训练的图像修复工具。该工具旨在帮助用户在任何稳定扩散模型(SD)上实现高质量的图像修复效果,甚至包括用户自己训练的自定义模型。LanPaint 通过多次迭代让模型在去噪之前 “思考”,从而获得更为无缝和准确的修复结果。LanPaint 的主要特点之一是零训练修复。用户可以立即在任何 SD 模型上使用该工具,无需进行繁琐的训练过程。此外,LanPaint 的集成十分简单,用户可以像使用标准的 ComfyUI KSampler 一样进行操作,流畅的工

还在对着音乐软件 “抠脚” 编曲? OUT 啦! 音乐创作领域迎来 “核爆级” 突破! 全球首个基于扩散模型的端到端音乐模型 DiffRhythm 横空出世, 直接把音乐创作的门槛 “夷为平地”! 你只需要 “动动嘴皮子”, 输入歌词和风格,10秒钟后, 一首包含 人声和伴奏 的完整歌曲就 “新鲜出炉”! DiffRhythm 这次是真的 “放大招” 了! 它彻底颠覆了传统的音乐创作模式, 实现了 端到端自动生成完整歌曲, 全程 无需任何人工干预! 你不再需要像 “老黄牛” 一样 “吭哧吭哧” 地编曲、 混音, 只需简

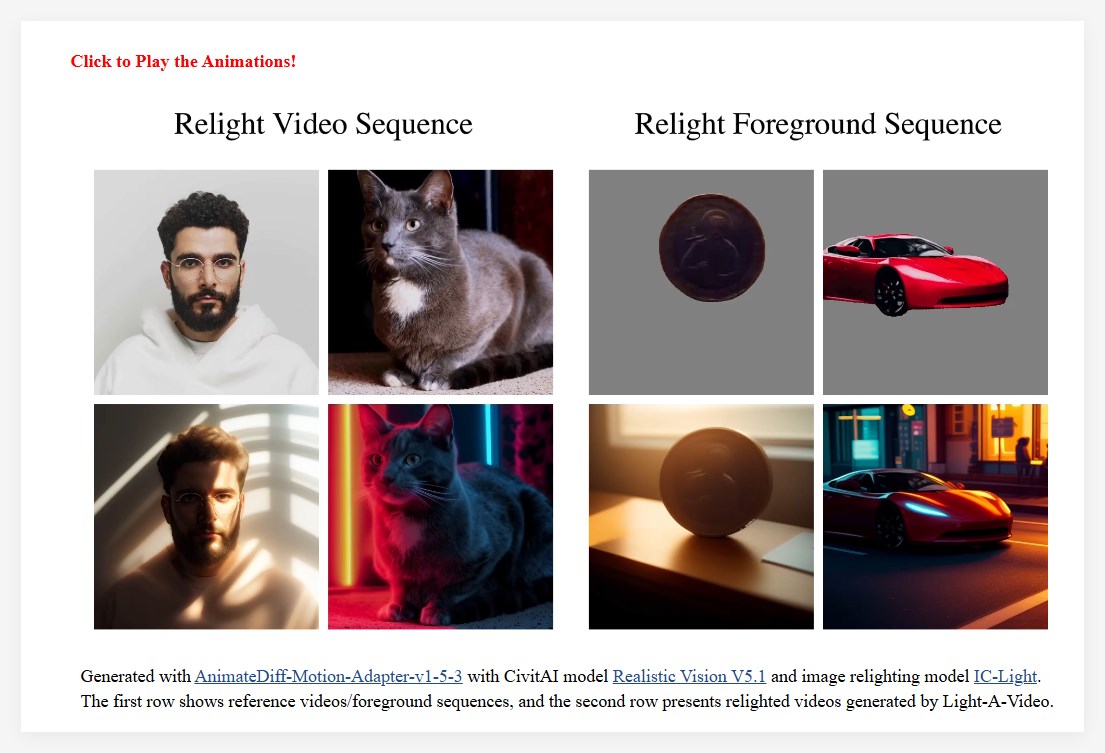

近年来,图像重光照技术的进步得益于大规模数据集和预训练的扩散模型,使得一致性光照的应用变得更加普遍。然而,在视频重光照领域,由于训练成本高昂以及缺乏多样化和高质量的视频重光照数据集,进展相对缓慢。仅仅将图像重光照模型逐帧应用于视频,会导致多种问题,如光源不一致和重光照外观不一致,最终导致生成的视频出现闪烁现象。为了解决这一问题,研究团队提出了 Light-A-Video,这是一种无需训练的、能够实现时间上平滑视频重光照的方法。Light-A-Video 借鉴了图像重光

来自纽约大学、麻省理工学院和谷歌的研究团队近日提出了一个创新框架,旨在解决扩散模型在推理时间扩展方面的瓶颈问题。这一突破性研究超越了传统简单增加去噪步骤的方法,为提升生成模型性能开辟了新途径。该框架主要从两个维度展开:一是利用验证器提供反馈,二是实施算法以发现更优的噪声候选。研究团队以256×256分辨率的预训练SiT-XL模型为基础,在保持250个固定去噪步骤的同时,创新性地引入了专用于搜索操作的额外计算资源。在验证系统方面,研究采用了两个Oracle Verifie

在游戏开发领域,场景的多样性和创新性一直是一个难题。近期,香港大学与快手科技联手研发了一个名为 GameFactory 的创新框架,旨在解决游戏视频生成中的场景泛化问题。这一框架利用了预训练的视频扩散模型,能够在开放域的视频数据上进行训练,从而生成全新且多样化的游戏场景。视频扩散模型作为一种先进的生成技术,近年来在视频生成和物理模拟领域展现出巨大潜力。这些模型能够像视频生成工具一样,响应用户的操作输入,如键盘和鼠标,进而生成相应的游戏画面。然而,场

微软研究院推出了一款名为 MatterGen 的强大人工智能系统,该系统能够生成具有特定性质的新材料,可能会加速电池、太阳能电池板等关键技术的开发。MatterGen 的推出标志着科学家们发现新材料的方法发生了根本性的变化。与传统方法不同,MatterGen 不再是筛选数百万个现有化合物,而是根据所需特性直接生成新材料,类似于 AI 图像生成器通过文本描述创建图片的方式。MatterGen 使用了一种特殊的 AI 模型,称为扩散模型,类似于 DALL-E 等图像生成器,但经过调整以适用于三维晶体结构。该系

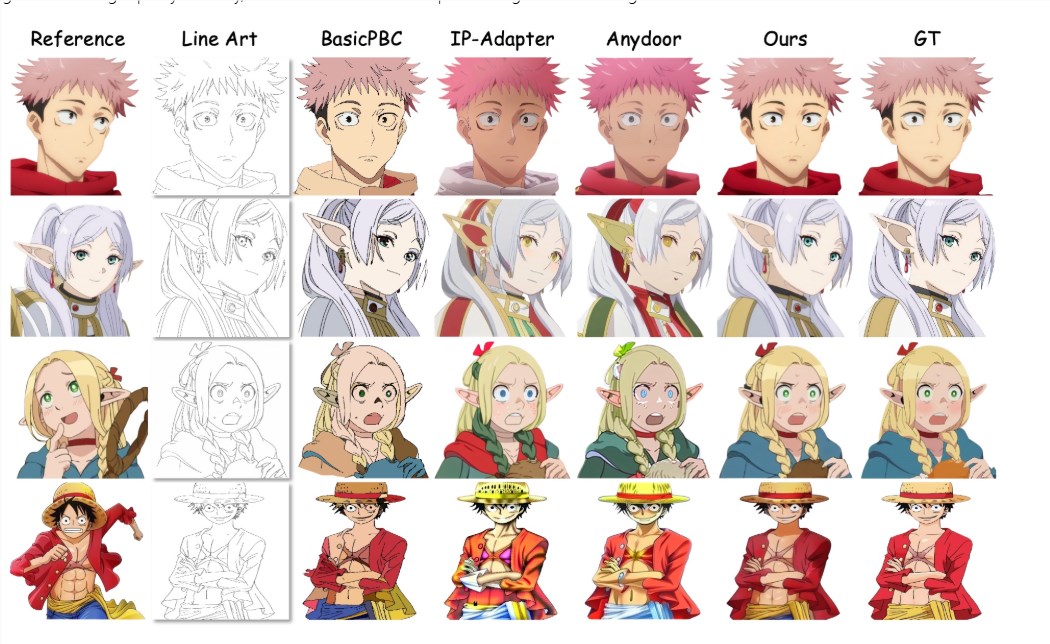

近日,一项名为 MangaNinja 的线稿上色方法引起了广泛关注,只需输入线稿和参考图,就能依据参考图给目标线稿上色。这项技术基于扩散模型,专注于参考图像引导的线稿上色,极大地提升了上色的精准度和互动控制能力。研究团队通过两项创新设计,确保了角色细节的精确传递。首先,他们引入了一个补丁重排模块,以促进参考彩色图像与目标线稿之间的对应学习。其次,采用了点驱动的控制方案,使得用户可以对颜色进行精细匹配。在他们的实验中,研究人员构建了一个自收集的基准

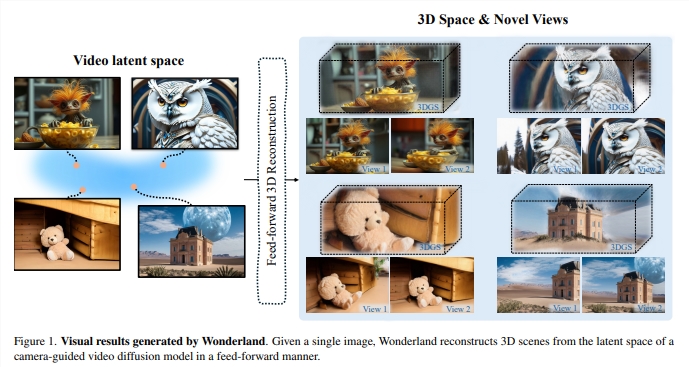

长期以来,如何仅凭单张图像高效生成高质量、广阔视角的3D场景一直是研究人员面临的挑战。传统方法往往依赖多视角数据,或需要耗时的逐场景优化,并且在背景质量和未见区域的重建上存在不足。现有技术在处理单视图3D场景生成时,常因信息不足而导致遮挡区域的错误或扭曲,背景模糊,以及难以推断未见区域的几何结构。而基于回归的模型虽然可以前馈方式进行新视角合成,但它们在处理复杂场景时面临巨大的内存和计算压力,因此大多局限于物体级别的生成或窄视角场景。为了