Na era em que empresas de tecnologia buscam integrar inteligência artificial em dispositivos, modelos de linguagem pequenos (SLMs) estão surgindo, capazes de funcionar em dispositivos com recursos limitados. Recentemente, a equipe de pesquisa da Nvidia, utilizando técnicas de ponta de poda e destilação de modelos, lançou o Llama-3.1-Minitron4B, uma versão compacta do modelo Llama3. Este novo modelo não apenas se compara em desempenho a modelos maiores, mas também compete com SLMs de tamanho semelhante, sendo mais eficiente em treinamento e implantação.

Poda e destilação são duas técnicas essenciais para criar modelos de linguagem menores e mais eficientes. Poda envolve remover partes não importantes do modelo, incluindo "poda profunda" – remover camadas inteiras – e "poda de largura" – remover elementos específicos, como neurônios e cabeças de atenção. Já a destilação de modelos transfere conhecimento e habilidades de um modelo grande (o "modelo professor") para um modelo menor e mais simples (o "modelo aluno").

Existem duas maneiras principais de destilação: a primeira, através do "treinamento SGD", onde o modelo aluno aprende as entradas e respostas do modelo professor; a segunda, a "destilação de conhecimento clássica", onde o modelo aluno aprende, além dos resultados, as ativações internas do modelo professor.

Em um estudo anterior, pesquisadores da Nvidia reduziram com sucesso o modelo Nemotron15B para um modelo de 800 milhões de parâmetros, usando poda e destilação, e depois para 400 milhões. Esse processo não apenas melhorou o desempenho em 16% no conhecido teste de referência MMLU, mas também reduziu em 40 vezes a quantidade de dados de treinamento necessários em comparação com o treinamento do zero.

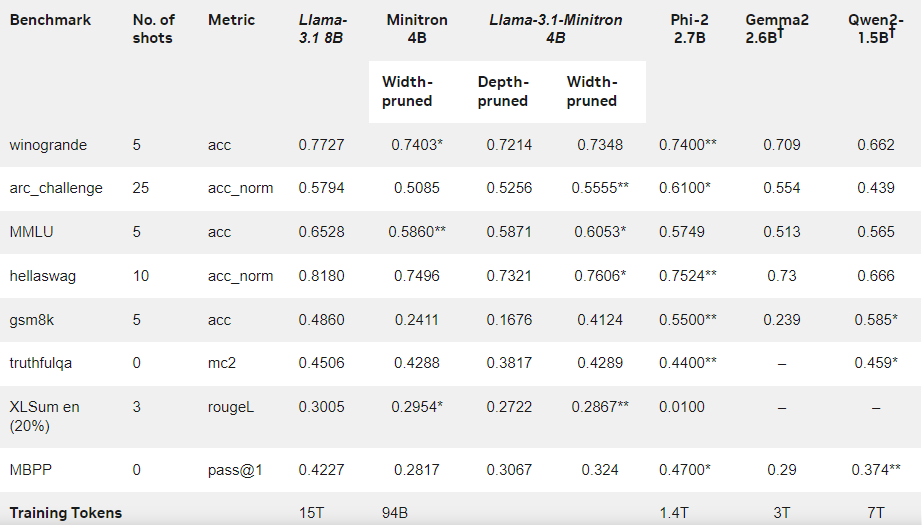

Desta vez, a equipe da Nvidia criou um modelo de 400 milhões de parâmetros baseado no modelo Llama3.18B, usando o mesmo método. Primeiro, eles fizeram o ajuste fino de um modelo de 8 bilhões de parâmetros não podado em um conjunto de dados contendo 94 bilhões de tokens, para lidar com a diferença de distribuição entre os dados de treinamento e os dados de destilação. Em seguida, usaram poda profunda e poda de largura, resultando em duas versões diferentes do Llama-3.1-Minitron4B.

Os pesquisadores fizeram o ajuste fino dos modelos podados usando o NeMo-Aligner e avaliaram suas capacidades em instruções de acompanhamento, interpretação de papéis, geração aprimorada por recuperação (RAG) e chamadas de funções.

Os resultados mostraram que, apesar da menor quantidade de dados de treinamento, o Llama-3.1-Minitron4B apresentou desempenho próximo a outros modelos pequenos, com resultados excelentes. A versão com poda de largura já foi lançada no Hugging Face, permitindo uso comercial e beneficiando usuários e desenvolvedores com seu desempenho eficiente e excepcional.

Blog oficial: https://developer.nvidia.com/blog/how-to-prune-and-distill-llama-3-1-8b-to-an-nvidia-llama-3-1-minitron-4b-model/

Destaques:

🌟 Llama-3.1-Minitron4B é um modelo de linguagem pequeno lançado pela Nvidia baseado em técnicas de poda e destilação, com capacidades eficientes de treinamento e implantação.

📈 O modelo usou 40 vezes menos tokens durante o treinamento do que o treinamento do zero, com uma melhoria significativa no desempenho.

🔓 A versão com poda de largura foi lançada no Hugging Face, permitindo uso comercial e desenvolvimento.