北大知识计算实验室与四川天府银行AI实验室合作,开源性能最强的CodeShell-7B代码基座大模型。该模型在多项评测中脱颖而出,开创了智能代码助手的新时代。此外,CodeShell-Chat提供多功能支持,而开源的IDE插件有助提高开发效率,使程序员轻松编程。

本文来自AIbase日报

欢迎来到【AI日报】栏目!这里是你每天探索人工智能世界的指南,每天我们为你呈现AI领域的热点内容,聚焦开发者,助你洞悉技术趋势、了解创新AI产品应用。

北大知识计算实验室与四川天府银行AI实验室合作,开源性能最强的CodeShell-7B代码基座大模型。该模型在多项评测中脱颖而出,开创了智能代码助手的新时代。此外,CodeShell-Chat提供多功能支持,而开源的IDE插件有助提高开发效率,使程序员轻松编程。

欢迎来到【AI日报】栏目!这里是你每天探索人工智能世界的指南,每天我们为你呈现AI领域的热点内容,聚焦开发者,助你洞悉技术趋势、了解创新AI产品应用。

近日,北京大学定量生物学中心的钱珑团队成功研发出全球首个专门用于功能基因挖掘的大语言模型 SYMPLEX。这一创新的模型能够从海量的生物文献中高效筛选出具有特定功能的关键基因,推动生物科技的发展。SYMPLEX 的问世,标志着基因挖掘技术进入了一个全新的阶段。团队利用这一模型,进行 mRNA 加帽酶基因的挖掘,并取得了显著的成果:新发现的加帽酶活性远超目前用于 mRNA 疫苗生产的商业化酶。这一成果不仅展示了大语言模型在生物制造领域的巨大潜力,也为未来的疫苗生产提供了

北京大学张牧涵团队提出了一种全新的框架——Long Input Fine-Tuning (LIFT),通过将长输入文本训练进模型参数中,使任意短上下文窗口模型获得长文本处理能力。这一方法颠覆了传统的长文本处理思路,不再专注于无限扩充上下文窗口,而是将长文本知识内化到模型参数中,类似于人类将工作记忆转化为长期记忆的过程。目前大模型处理长文本面临两大主要挑战:传统注意力机制的平方复杂度导致处理长文本时计算和内存开销巨大 模型难以理解散落在长文本各处的长程依赖关系现有的解决

12月12日,北京大学与字节跳动正式宣布成立豆包大模型系统软件联合实验室,标志着中国 AI 领域产学研合作迈上新台阶。该联合实验室的科研工作将以字节跳动自研的豆包大模型为基础。来自高校和企业的科研人员将在实验室内,围绕大模型的训练、推理等关键技术展开深入研究。随着实验室的建设和发展,还将有大批北京大学学生进入实验室实习实践,与产业一线的科研人员并肩作战,共同推进 AI 技术进步。字节跳动豆包大模型团队成立于2023年,研究方向涵盖深度学习、强化学习、L

北京大学软件工程国家工程研究中心与教育学院联合研发的博雅人工智能教育大模型于12月8日在北京发布。这一大模型由多个不同学科的专业大模型系列组成,具备强大的学科专业教育能力,能够广泛应用于高等院校、职业院校及中小学的学科教学场景中,实现大规模的因材施教和个性化教学。该大模型结合国内教学数据自主研发,旨在打造成为中国版的人工智能教育大模型,以推动教育领域的数字化转型和智能化升级。发布会上,还推出了基于博雅教育大模型的“北大智学”教学平台和

近日,北京大学等科研团队宣布发布了一款名为 LLaVA-o1的多模态开源模型,据称这是首个能够进行自发、系统推理的视觉语言模型,堪比 GPT-o1。该模型在六个具有挑战性的多模态基准测试中表现优异,其11B 参数的版本超越了其他竞争者,如 Gemini-1.5-pro、GPT-4o-mini 和 Llama-3.2-90B-Vision-Instruct。LLaVA-o1基于 Llama-3.2-Vision 模型,采用了 “慢思考” 推理机制,能够自主进行更加复杂的推理过程,超越了传统的思维链提示方法。在多模态推理基准测试中,LLaVA-o1的表现超出了其基础模型8.9%。该模型的

随着AIGC技术的快速发展,图像编辑工具日益强大,图像篡改变得更加容易,也更难被察觉。 虽然现有的图像篡改检测和定位方法(IFDL)通常很有效,但它们往往面临两大挑战:一是“黑匣子”性质,检测原理不明;二是泛化能力有限,难以应对多种篡改方法(如Photoshop、DeepFake、AIGC编辑)。 为解决这些问题,北京大学的研究团队提出了可解释的IFDL任务,并设计了FakeShield,这是一个多模态框架,能够评估图像的真实性,生成篡改区域掩码,并基于像素级和图像级的篡改线索提供判断依据。传统

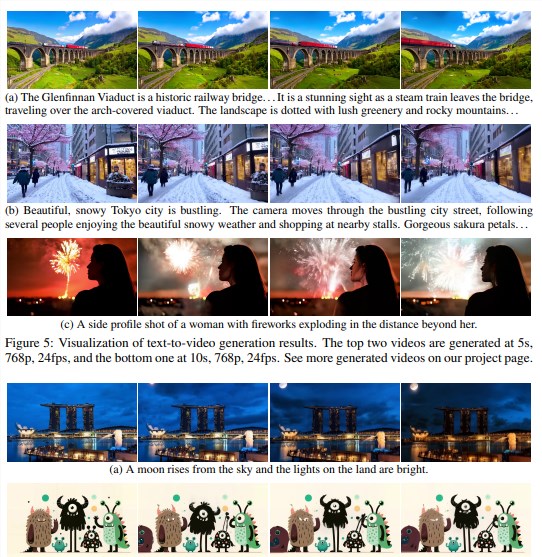

快手、北京大学和北京邮电大学的研究团队联手推出了一项重磅科技成果——Pyramid-Flow超高清视频模型。这一开源项目在人工智能生成视频领域取得了显著突破,为行业带来了新的可能性。Pyramid-Flow模型展现了惊人的能力,仅需文本输入即可生成长达10秒、分辨率高达1280x768、帧率24fps的高质量视频。无论是光影效果、动作连贯性、整体画质、文本语义还原,还是色彩搭配,Pyramid-Flow都表现出色,生成的视频令人叹为观止。这项技术的一大亮点在于其高效的训练过程。研究团队仅使用A100GPU在

最近,快手和北京大学以及北京邮电大学的研究团队共同开源了一个名为 Pyramid-Flow 的超高清视频生成模型。这个模型能够通过文本描述生成最高10秒、1280x768分辨率、24帧的视频,质量相当出色,光影效果、动作一致性、视频质量等方面表现都很不错。Pyramid Flow 的工作原理与现有的视频扩散模型不同。现有模型通常在全分辨率下运行,这样做虽然能产生高质量的结果,但却消耗了大量计算资源。而 Pyramid Flow 则采用了流匹配的灵活性,可以在不同分辨率和噪声水平之间进行插值,这样就能

随着OpenAI的GPT-4在传统数学评测中屡创佳绩,北京大学和阿里巴巴的研究团队联手推出了一个全新的评测基准——Omni-MATH,旨在评估大型语言模型在奥林匹克数学竞赛级别的推理能力。这一举措不仅为AI数学能力的评估提供了新标准,也为探索AI在高级数学领域的潜力开辟了新途径。Omni-MATH的独特设计Omni-MATH评测库包含4428道竞赛级别的数学问题,涵盖33个以上的数学子领域,难度分为10个不同级别。其特点包括:高可靠性:所有题目均来自各种数学竞赛和论坛,答案经过人工验证。广泛覆盖:从

在AI技术蓬勃发展的背景下,提示工程作为一门关键的技术,通过巧妙设计的提示引导AI更精准理解人类意图,提高AI响应的准确性。然而,这一过程对普通用户而言具有较高的门槛。为解决这一问题,北京大学和百川科技的科学家团队共同开发了PAS(Prompt Augmentation System),一个基于大型语言模型的智能提示增强系统。PAS在数据利用、兼容性、灵活性和性能上表现出色,显著提升了AI理解和响应人类需求的能力。其工作原理包括高质量提示的筛选和补充提示的自动生成,实验结果显示,PAS在逻辑推理、语言翻译和问答能力等多个基准测试中均取得了最佳成绩,极大地降低了提示工程的门槛,为AI技术的普及和深化应用铺平了道路。