En la era actual, dominada por la ola digital que inunda el mundo, las imágenes virtuales se han convertido silenciosamente en una parte esencial de nuestra vida diaria.

Sin embargo, los usuarios que suelen trabajar con la generación de videos a partir de imágenes y la sincronización labial se han encontrado con un problema incómodo: por más realista que sea la generación de tu "personaje", al abrir la boca se delata.

Nota de la fuente: Imagen generada por IA, proveedor de servicios de licencias de imágenes Midjourney

En pocas palabras, el sonido y la imagen están completamente desconectados. Cualquiera puede darse cuenta de que la voz no corresponde a la persona que se ve en la imagen, o que el sonido no es el adecuado para esa escena.

¡Ahora, este incómodo problema finalmente tiene solución!

Recientemente, ha surgido una innovadora tecnología llamada LOOPY, que no solo supera las limitaciones de la animación tradicional de personajes virtuales, sino que también aporta al mundo digital una vitalidad sin precedentes.

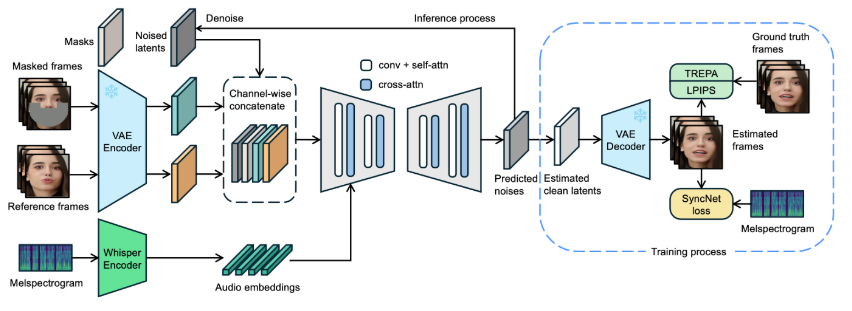

Esta tecnología, desarrollada conjuntamente por los equipos de investigación de ByteDance y la Universidad de Zhejiang, se basa en un modelo de difusión de video impulsado por audio. A diferencia de las tecnologías anteriores que requerían complejos sistemas de señales espaciales auxiliares, LOOPY solo necesita una imagen y una entrada de audio para generar sorprendentes efectos dinámicos en el personaje virtual.

El núcleo de esta tecnología reside en su exclusivo módulo de captura de información de movimiento a largo plazo. Loopy admite diversos estilos visuales y de audio; es como un coreógrafo experimentado que "dirige" con precisión cada pequeño movimiento del personaje virtual según el ritmo y la emoción del audio. Por ejemplo, acciones no verbales como suspiros, movimientos de cejas y ojos impulsados por las emociones, y movimientos naturales de la cabeza.

Por ejemplo, en este video, los movimientos de los ojos y el cuello de Taylor mientras habla coinciden perfectamente con las expectativas. Al observarla hablar, se percibe de forma natural que así es como debería moverse al hablar. Incluso los sonidos ambientales y de la escena durante la conversación parecen "lógicos".

LOOPY también ofrece resultados sorprendentes con personajes no realistas. Ya sea la expresión sutil de un cantante, los cambios en las cejas y los ojos sincronizados con las emociones, o incluso un suave suspiro, LOOPY lo representa a la perfección.

Más sorprendente aún, puede generar diversos efectos de movimiento para la misma imagen de referencia según el audio, desde apasionados hasta suaves y delicados. Esta flexibilidad ofrece a los creadores un espacio ilimitado para la imaginación.

En aplicaciones reales, LOOPY ha demostrado un rendimiento excepcional. Las pruebas en varios conjuntos de datos del mundo real muestran que no solo supera con creces a los modelos de difusión de retratos impulsados por audio existentes en cuanto a naturalidad, sino que también genera resultados de alta calidad y realismo en diversas situaciones complejas.

Cabe destacar que LOOPY también funciona excepcionalmente bien con retratos de perfil, lo que sin duda impulsará aún más la expresividad de los personajes virtuales.

La aparición de LOOPY ha abierto sin duda una nueva puerta para el mundo virtual. No solo puede destacar en áreas como juegos, producción cinematográfica y realidad virtual, mejorando la experiencia del usuario, sino que también ofrece a los creadores una plataforma creativa más amplia. Con el avance continuo de la tecnología, el potencial de LOOPY se está explorando aún más, y es probable que se convierta en un nuevo referente en el desarrollo futuro de la tecnología de personajes virtuales.

Dirección del proyecto: https://loopyavatar.github.io/