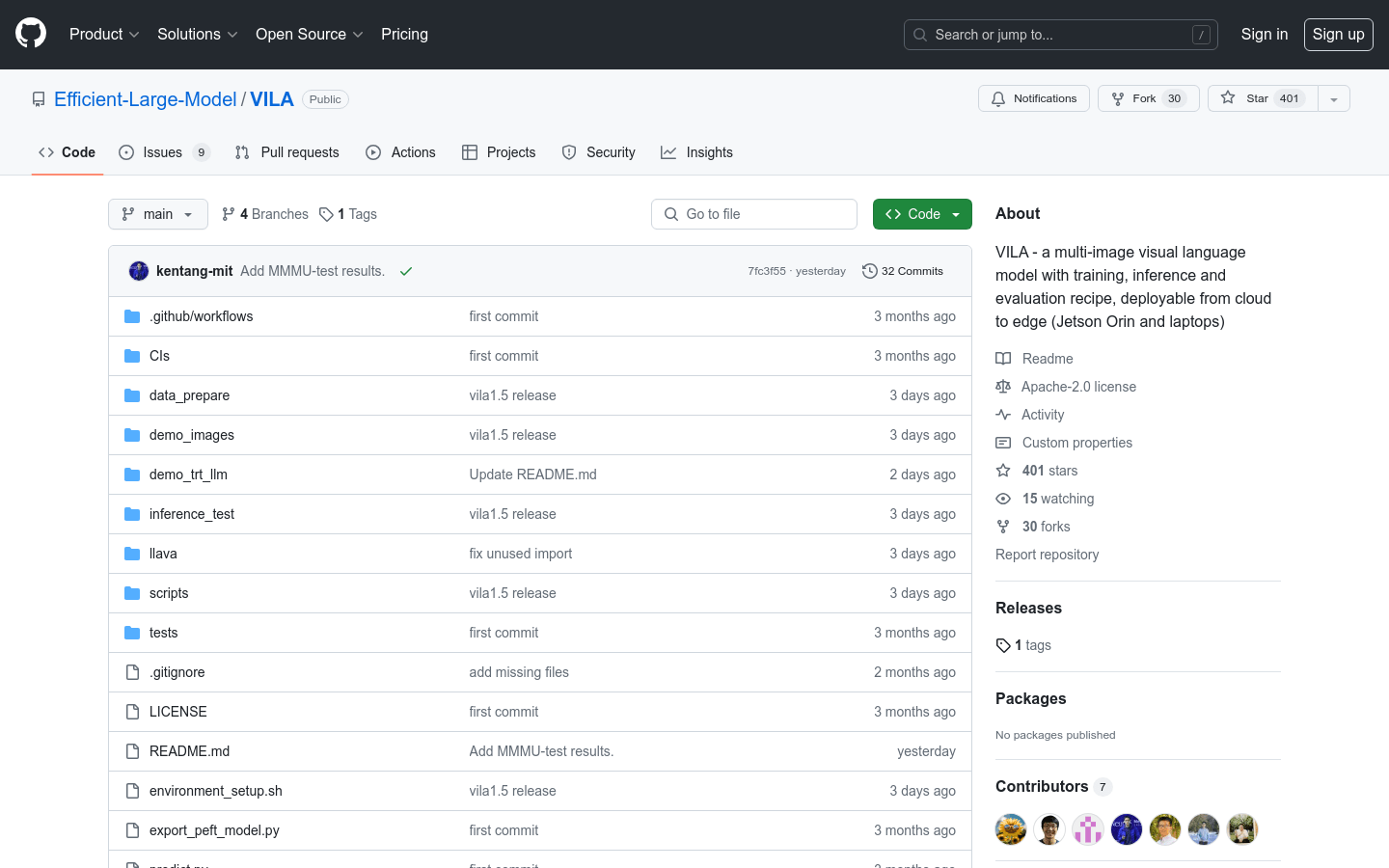

VILA

Un modelo de lenguaje visual multiimagen que cuenta con esquemas de entrenamiento, inferencia y evaluación, y que se puede implementar desde la nube hasta dispositivos de borde (como Jetson Orin y computadoras portátiles).

Producto ComúnImagenModelo de lenguaje visualComprensión de video

VILA es un modelo de lenguaje visual (VLM) preentrenado con datos de imagen-texto entrelazados a gran escala para lograr la comprensión de video y la comprensión de múltiples imágenes. VILA se puede implementar en dispositivos de borde mediante la cuantificación AWQ de 4 bits y el marco TinyChat. Las principales ventajas incluyen: 1) Los datos de imagen-texto entrelazados son cruciales para mejorar el rendimiento; 2) No congelar el modelo de lenguaje grande (LLM) durante el preentrenamiento de imagen-texto entrelazado promueve el aprendizaje contextual; 3) La remezcla de datos de instrucciones de texto es crucial para mejorar el rendimiento del VLM y del texto puro; 4) La compresión de tokens puede ampliar el número de fotogramas de video. VILA demuestra capacidades fascinantes que incluyen razonamiento de video, aprendizaje contextual, cadena de pensamiento visual y un mejor conocimiento del mundo.

VILA Situación del tráfico más reciente

Total de visitas mensuales

474564576

Tasa de rebote

36.20%

Páginas promedio por visita

6.1

Duración promedio de la visita

00:06:34