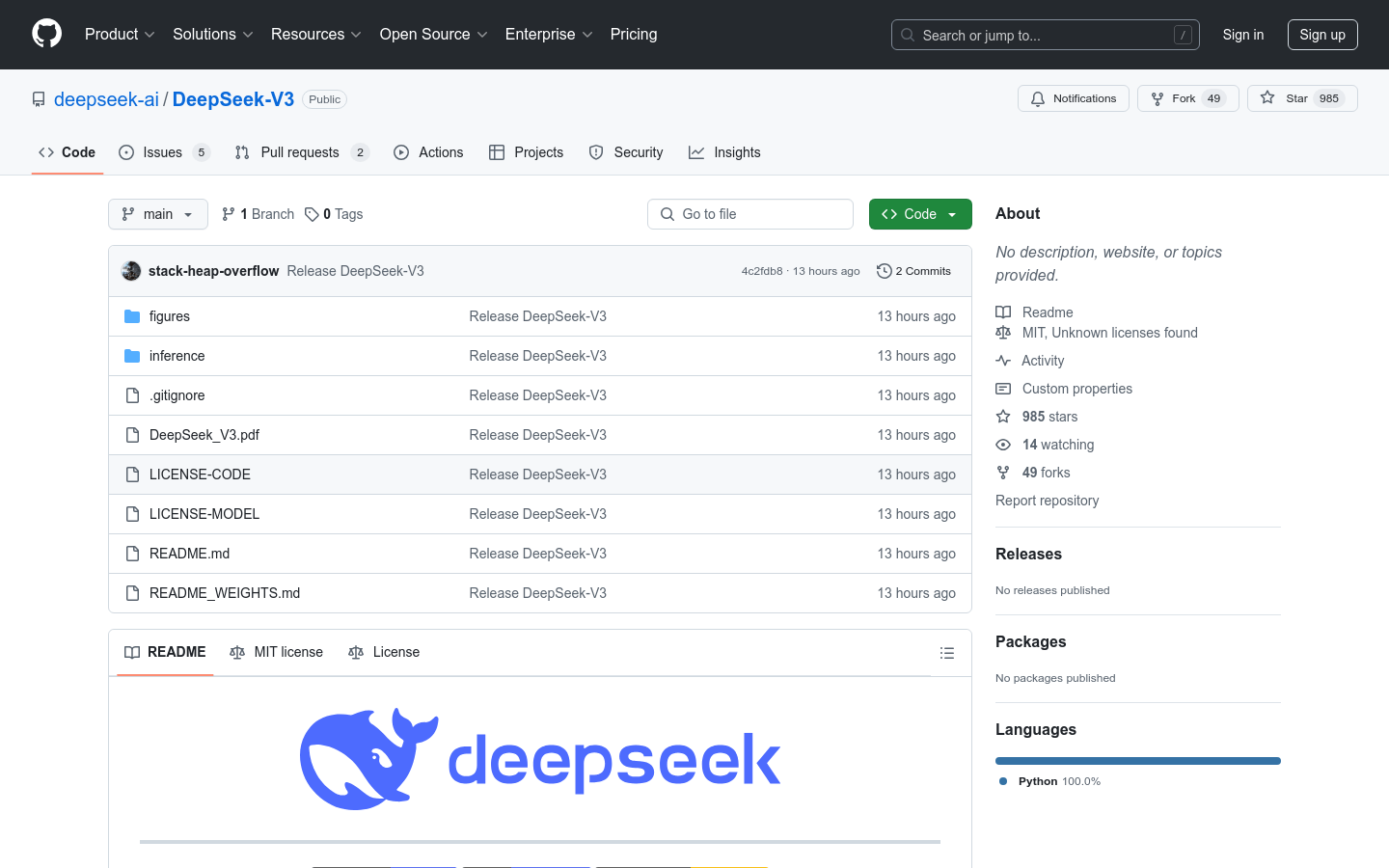

DeepSeek-V3

Modèle linguistique Mixture-of-Experts (MoE) de 671 milliards de paramètres.

Sélection NationaleProductivitéTraitement du langage naturelApprentissage profond

DeepSeek-V3 est un puissant modèle linguistique Mixture-of-Experts (MoE) doté de 671 milliards de paramètres au total, dont 37 milliards activés à chaque fois. Il utilise l'architecture Multi-head Latent Attention (MLA) et DeepSeekMoE, déjà éprouvées dans DeepSeek-V2. De plus, DeepSeek-V3 intègre pour la première fois une stratégie d'équilibrage de charge sans perte auxiliaire et un objectif d'entraînement de prédiction multi-jetons pour des performances accrues. DeepSeek-V3 a été pré-entraîné sur 14,8 billions de jetons de haute qualité, puis affiné de manière supervisée et via un apprentissage par renforcement pour exploiter pleinement ses capacités. Les évaluations globales montrent que DeepSeek-V3 surpasse les autres modèles open source et atteint des performances comparables aux modèles propriétaires de pointe. Malgré ses performances exceptionnelles, l'entraînement complet de DeepSeek-V3 n'a nécessité que 2,788 millions d'heures GPU H800, avec une grande stabilité.

DeepSeek-V3 Dernière situation du trafic

Nombre total de visites mensuelles

474564576

Taux de rebond

36.20%

Nombre moyen de pages par visite

6.1

Durée moyenne de la visite

00:06:34