In der Welt der künstlichen Intelligenz gibt es eine Gruppe besonderer „Künstler“ – die hierarchischen Strukturen in Transformer-Modellen. Sie sind wie magische Pinsel, die auf der Leinwand der Sprache eine farbenfrohe Welt malen. Eine kürzlich erschienene Arbeit mit dem Titel „Transformer Layers as Painters“ bietet uns eine neue Perspektive auf das Verständnis der Funktionsweise der Zwischenschichten von Transformatoren.

Transformer-Modelle, die derzeit beliebtesten großen Sprachmodelle, verfügen über Milliarden von Parametern. Jede Schicht ist wie ein Künstler, der gemeinsam an einem großen Sprachgemälde arbeitet. Aber wie arbeiten diese „Künstler“ zusammen? Welche „Pinsel“ und „Farben“ verwenden sie? Diese Arbeit versucht, diese Fragen zu beantworten.

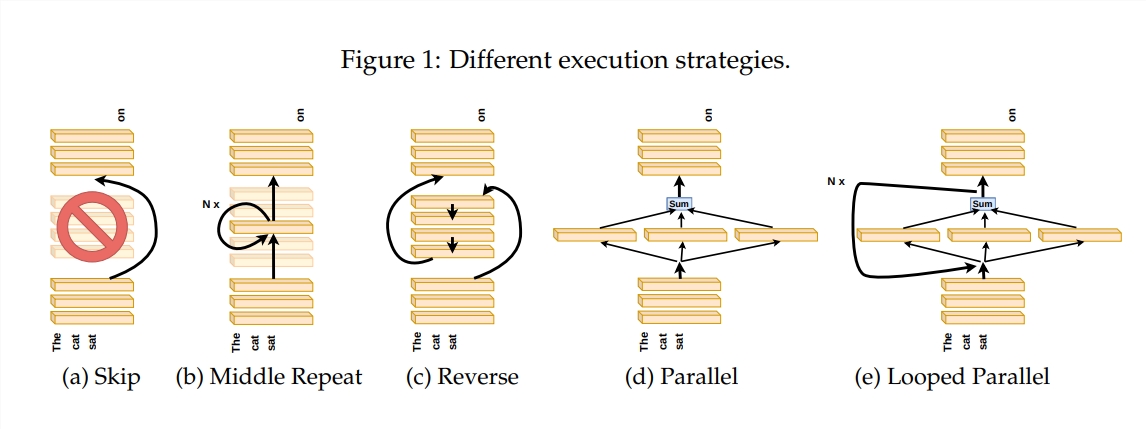

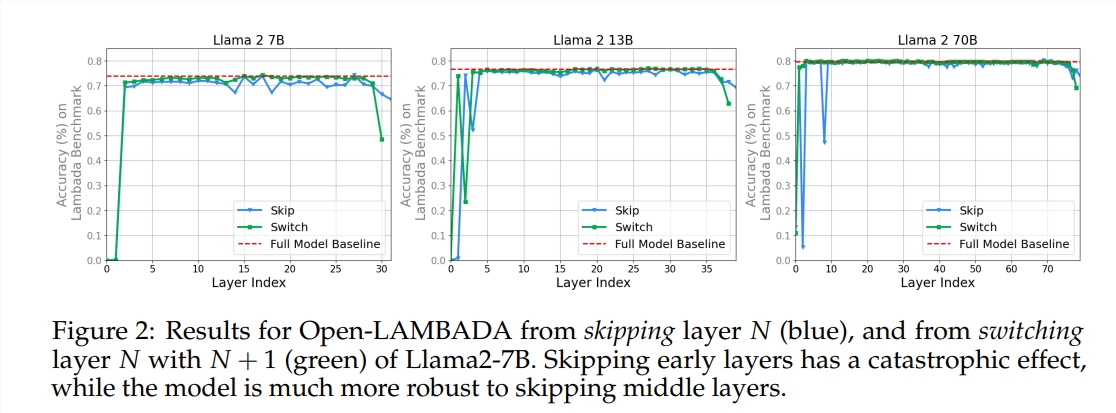

Um die Funktionsweise der Transformatorschichten zu untersuchen, haben die Autoren eine Reihe von Experimenten durchgeführt, darunter das Überspringen bestimmter Schichten, das Ändern der Reihenfolge der Schichten oder das parallele Ausführen von Schichten. Diese Experimente sind vergleichbar mit dem Festlegen verschiedener Malregeln für die „Künstler“, um zu sehen, ob sie sich anpassen können.

In der Metapher der „Künstler-Pipeline“ wird die Eingabe als Leinwand betrachtet, und der Prozess der Zwischenschichten ist wie die Weitergabe der Leinwand durch die Pipeline. Jeder „Künstler“, also jede Schicht des Transformators, verändert das Kunstwerk nach seinen Fähigkeiten. Diese Analogie hilft uns, die Parallelität und Anpassungsfähigkeit der Transformatorschichten zu verstehen.

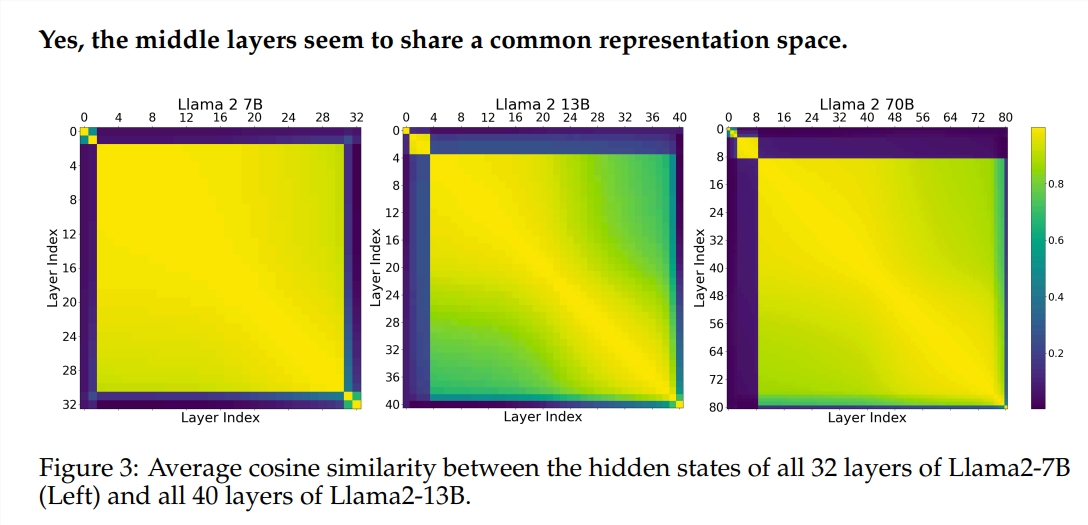

Die Experimente verwendeten zwei vortrainierte große Sprachmodelle (LLM): Llama2-7B und BERT. Die Studie ergab, dass die „Künstler“ der Zwischenschichten einen gemeinsamen „Farbkasten“ – den Repräsentationsraum – zu teilen scheinen, der sich von den Anfangs- und Endschichten unterscheidet. Das Überspringen bestimmter „Künstler“ der Zwischenschichten hat keinen großen Einfluss auf das gesamte Gemälde, was darauf hindeutet, dass nicht alle „Künstler“ notwendig sind.

Obwohl die „Künstler“ der Zwischenschichten denselben „Farbkasten“ verwenden, erzeugen sie doch mit ihren jeweiligen Fähigkeiten unterschiedliche Muster auf der Leinwand. Wenn man einfach die Fähigkeiten eines bestimmten „Künstlers“ wiederholt, verliert das Gemälde seinen Reiz.

Bei mathematischen und logischen Aufgaben, die eine strenge Logik erfordern, ist die Reihenfolge des „Malens“ besonders wichtig. Bei Aufgaben, die auf dem semantischen Verständnis beruhen, ist der Einfluss der Reihenfolge geringer.

Die Ergebnisse zeigen, dass die Zwischenschichten des Transformators ein gewisses Maß an Konsistenz aufweisen, aber nicht redundant sind. Bei mathematischen und logischen Aufgaben ist die Reihenfolge der Schichten wichtiger als bei semantischen Aufgaben.

Die Studie ergab auch, dass nicht alle Schichten notwendig sind und Zwischenschichten übersprungen werden können, ohne die Modellleistung katastrophal zu beeinträchtigen. Obwohl die Zwischenschichten denselben Repräsentationsraum teilen, erfüllen sie unterschiedliche Funktionen. Eine Änderung der Ausführungsreihenfolge der Schichten führt zu Leistungseinbußen, was zeigt, dass die Reihenfolge einen wichtigen Einfluss auf die Modellleistung hat.

Auf dem Weg zur Erforschung von Transformer-Modellen versuchen viele Forscher, diese zu optimieren, einschließlich Pruning und Parameterreduktion. Diese Arbeiten liefern wertvolle Erfahrungen und Erkenntnisse zum Verständnis von Transformer-Modellen.