OLMoE-1B-7B

高効率・オープンソースの大規模言語モデル

一般製品生産性大規模言語モデルオープンソース

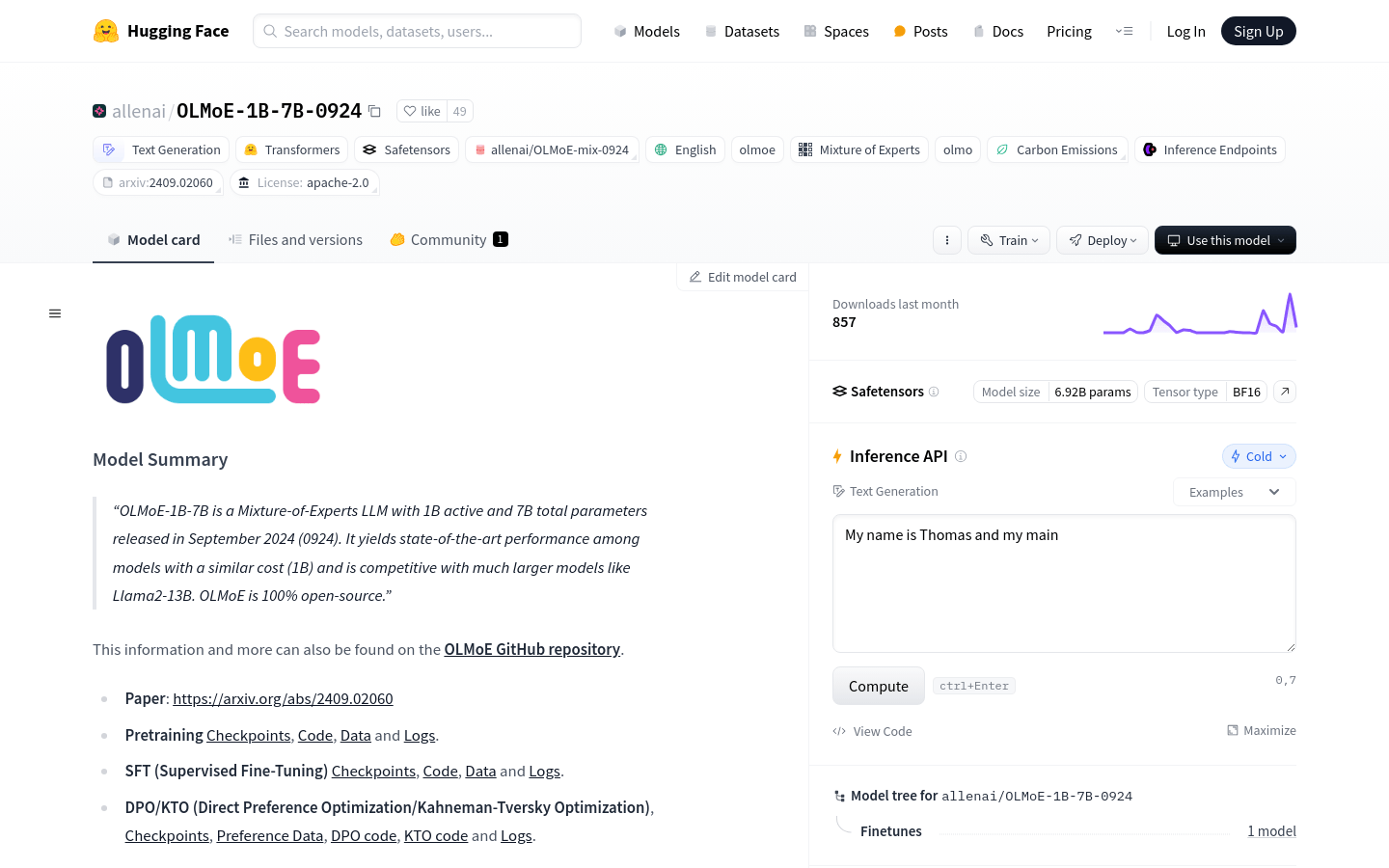

OLMoE-1B-7Bは、1億の活性化パラメータと7億の総パラメータを持つ、専門家混合型大規模言語モデル(LLM)であり、2024年9月にリリースされました。同等の計算コストのモデルの中では優れた性能を示し、Llama2-13Bなどのより大規模なモデルと競合します。OLMoEは完全にオープンソースであり、テキスト生成、モデル訓練、デプロイなど、多様な機能をサポートしています。

OLMoE-1B-7B 最新のトラフィック状況

月間総訪問数

29742941

直帰率

44.20%

平均ページ/訪問

5.9

平均訪問時間

00:04:44