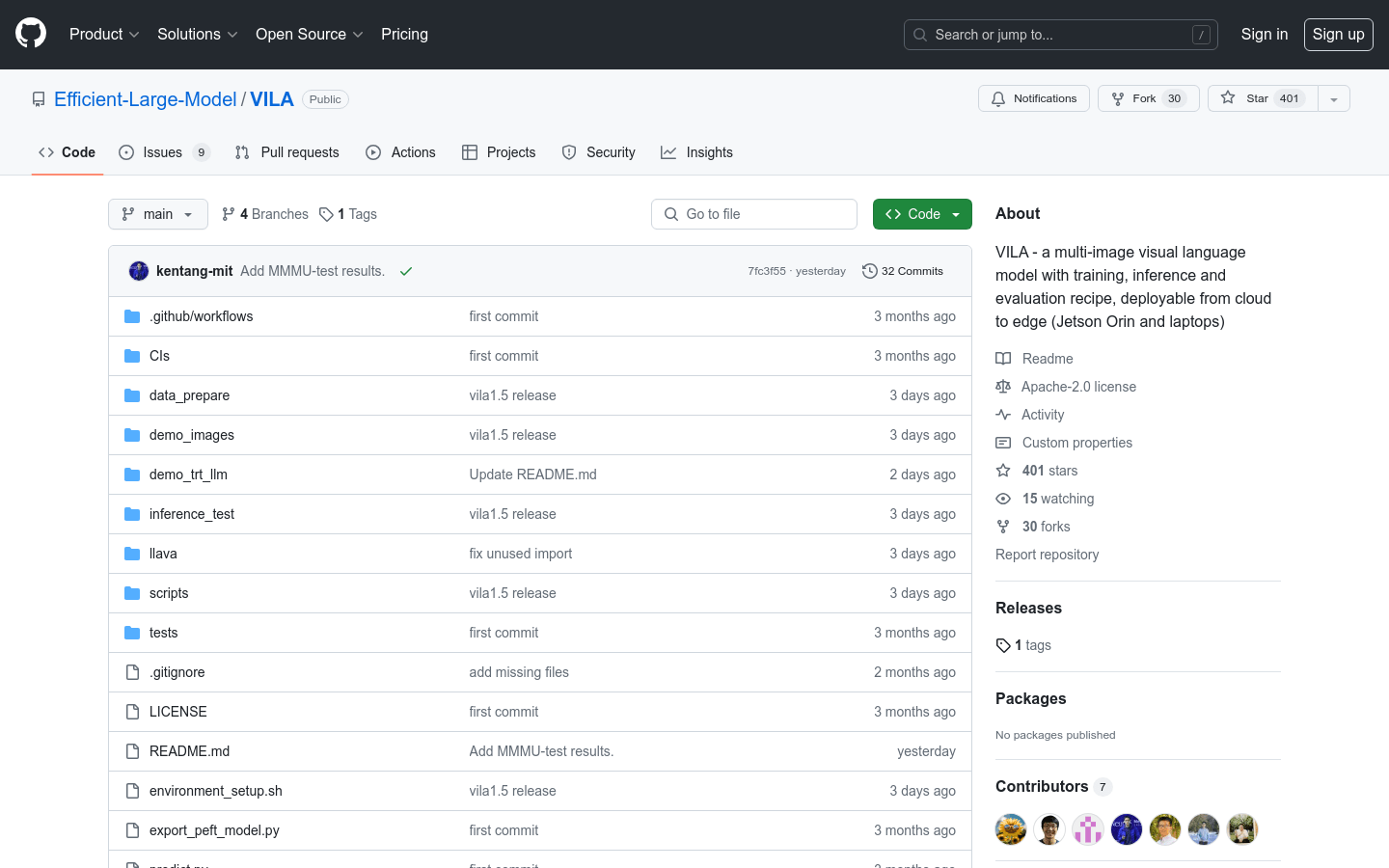

VILA

Um modelo de linguagem visual com múltiplas imagens, com esquemas de treinamento, inferência e avaliação, podendo ser implantado na nuvem ou em dispositivos de borda (como Jetson Orin e laptops).

Produto ComumImagemModelo de Linguagem VisualCompreensão de Vídeo

O VILA é um modelo de linguagem visual (VLM) pré-treinado com dados massivos de imagem-texto intercalados, permitindo a compreensão de vídeo e de múltiplas imagens. O VILA pode ser implantado em dispositivos de borda através da quantização AWQ de 4 bits e da estrutura TinyChat. As principais vantagens incluem: 1) Dados de imagem-texto intercalados são cruciais para o aprimoramento do desempenho; 2) Não congelar o modelo de linguagem grande (LLM) durante o pré-treinamento de imagem-texto intercalado promove o aprendizado de contexto; 3) O re-mix de dados de instruções de texto é crucial para melhorar o desempenho do VLM e de texto puro; 4) A compressão de tokens permite a ampliação do número de quadros de vídeo. O VILA demonstra capacidades interessantes, incluindo raciocínio em vídeo, aprendizado de contexto, cadeia de pensamento visual e melhor conhecimento de mundo.

VILA Situação do Tráfego Mais Recente

Total de Visitas Mensais

474564576

Taxa de Rejeição

36.20%

Média de Páginas por Visita

6.1

Duração Média da Visita

00:06:34