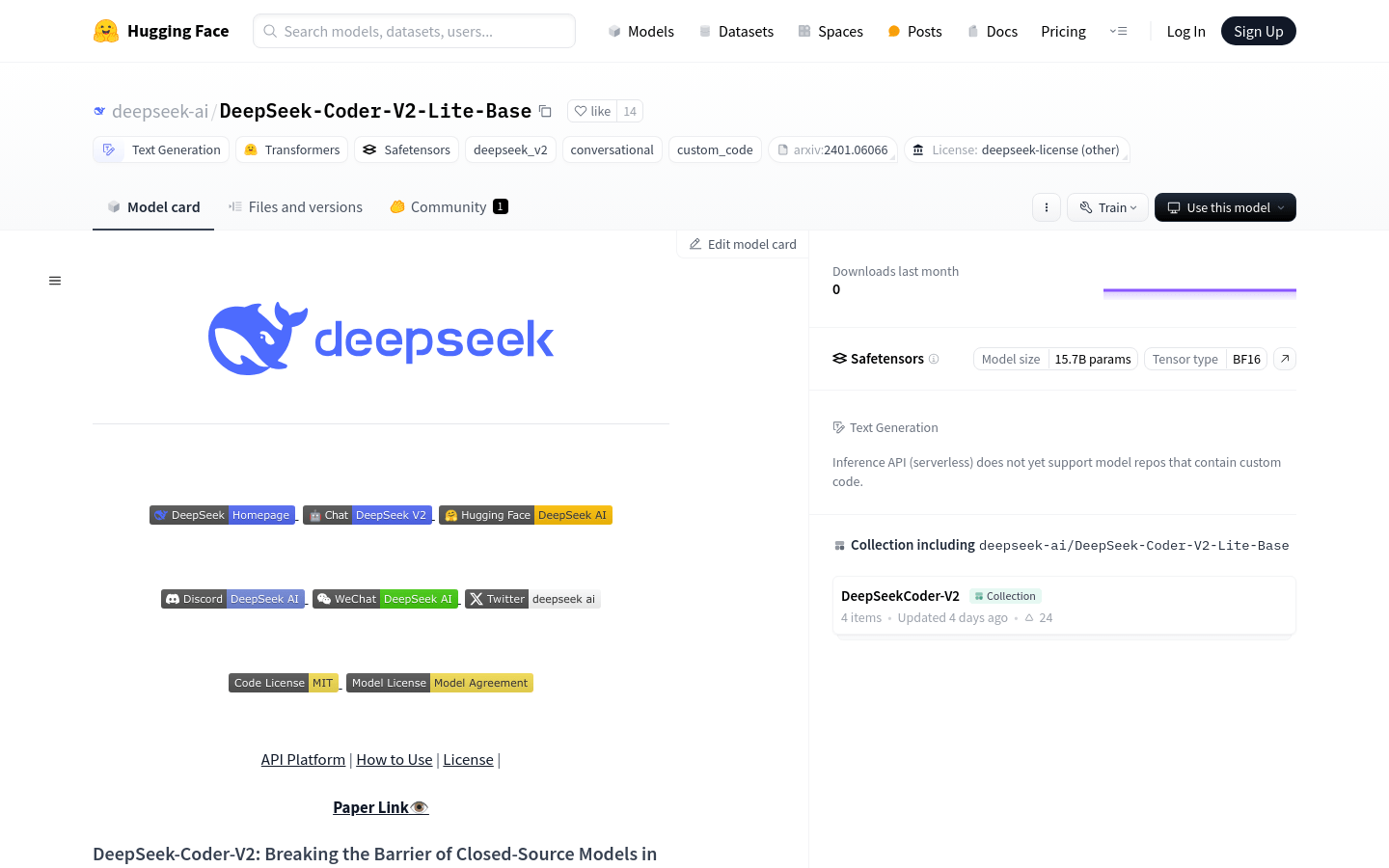

DeepSeek-Coder-V2-Lite-Base

Open-Source Code-Sprachmodell zur Verbesserung der Programmier- und mathematischen Schlussfolgerungsfähigkeiten.

Normales ProduktProgrammierungCodegenerierungOpen Source

DeepSeek-Coder-V2 ist ein quelloffenes Experten-Mix-Modell (Mixture-of-Experts, MoE), das speziell für Code-Sprachen entwickelt wurde und eine vergleichbare Leistung wie GPT4-Turbo bietet. Es zeichnet sich durch hervorragende Leistung bei codespezifischen Aufgaben aus und behält gleichzeitig eine angemessene Leistung bei allgemeinen Sprach-Aufgaben. Im Vergleich zu DeepSeek-Coder-33B weist die V2-Version eine deutliche Verbesserung bei codebezogenen Aufgaben und der Schlussfolgerungsfähigkeit auf. Darüber hinaus wurde die Unterstützung für Programmiersprachen von 86 auf 338 erweitert, und die Kontextlänge wurde von 16K auf 128K erhöht.

DeepSeek-Coder-V2-Lite-Base Neueste Verkehrssituation

Monatliche Gesamtbesuche

29742941

Absprungrate

44.20%

Durchschnittliche Seiten pro Besuch

5.9

Durchschnittliche Besuchsdauer

00:04:44