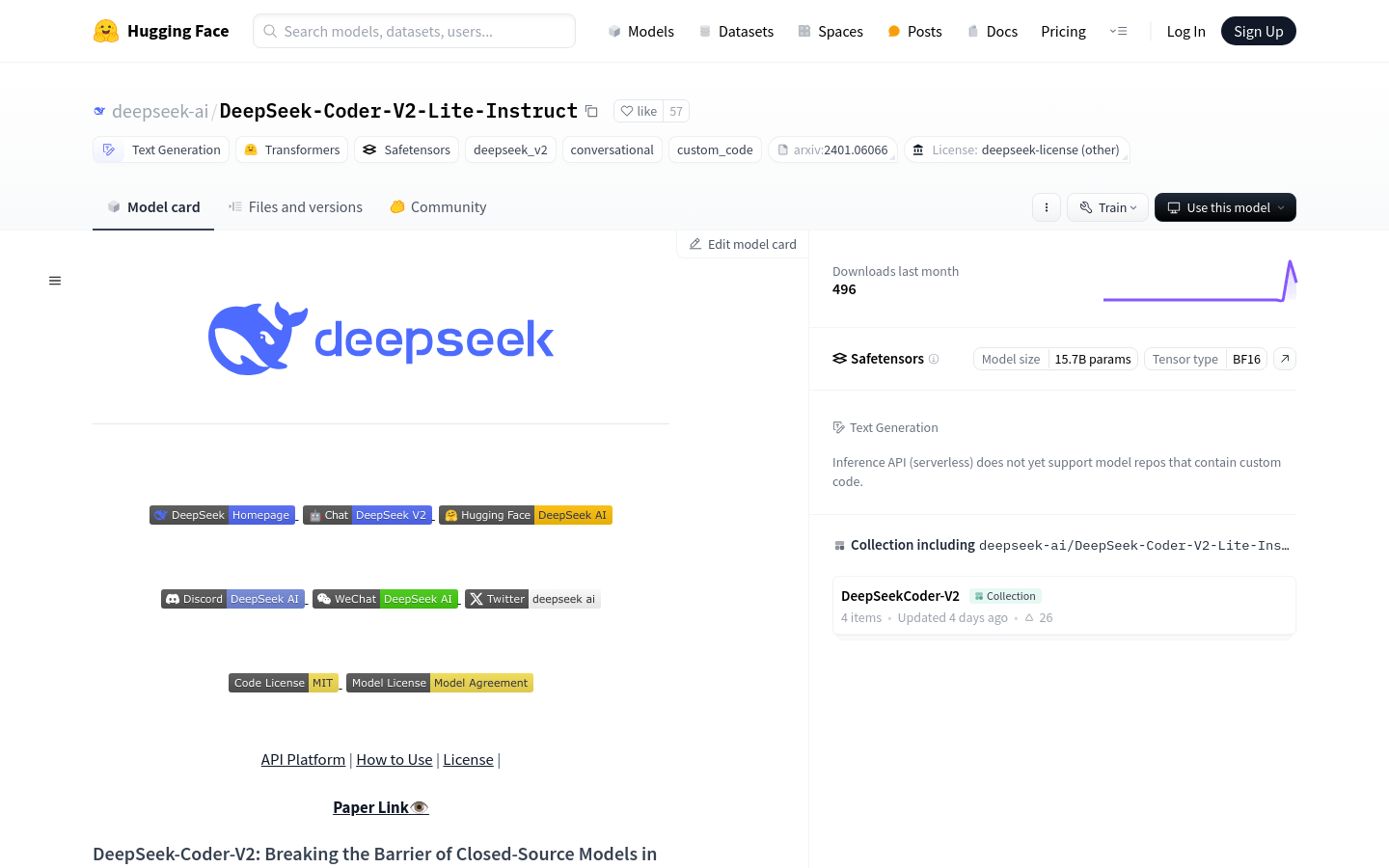

DeepSeek-Coder-V2-Lite-Instruct

Open-Source-Code-Sprachmodell, unterstützt mehrere Programmiersprachen.

Normales ProduktProgrammierungCodegenerierungMathematische Argumentation

DeepSeek-Coder-V2 ist ein Open-Source Mixture-of-Experts Code-Sprachmodell, dessen Leistung mit GPT4-Turbo vergleichbar ist und das bei code-spezifischen Aufgaben hervorragende Ergebnisse liefert. Durch zusätzliches Pretraining mit 6 Billionen Token wurden die Fähigkeiten in der Kodierung und mathematischen Argumentation verbessert, während die Leistung bei allgemeinen Sprach-Aufgaben erhalten blieb. Im Vergleich zu DeepSeek-Coder-33B zeigt es signifikante Fortschritte bei code-bezogenen Aufgaben, Schlussfolgerungen und allgemeinen Fähigkeiten. Darüber hinaus wurde die Unterstützung von Programmiersprachen von 86 auf 338 erweitert, und die Kontextlänge von 16K auf 128K erhöht.

DeepSeek-Coder-V2-Lite-Instruct Neueste Verkehrssituation

Monatliche Gesamtbesuche

29742941

Absprungrate

44.20%

Durchschnittliche Seiten pro Besuch

5.9

Durchschnittliche Besuchsdauer

00:04:44