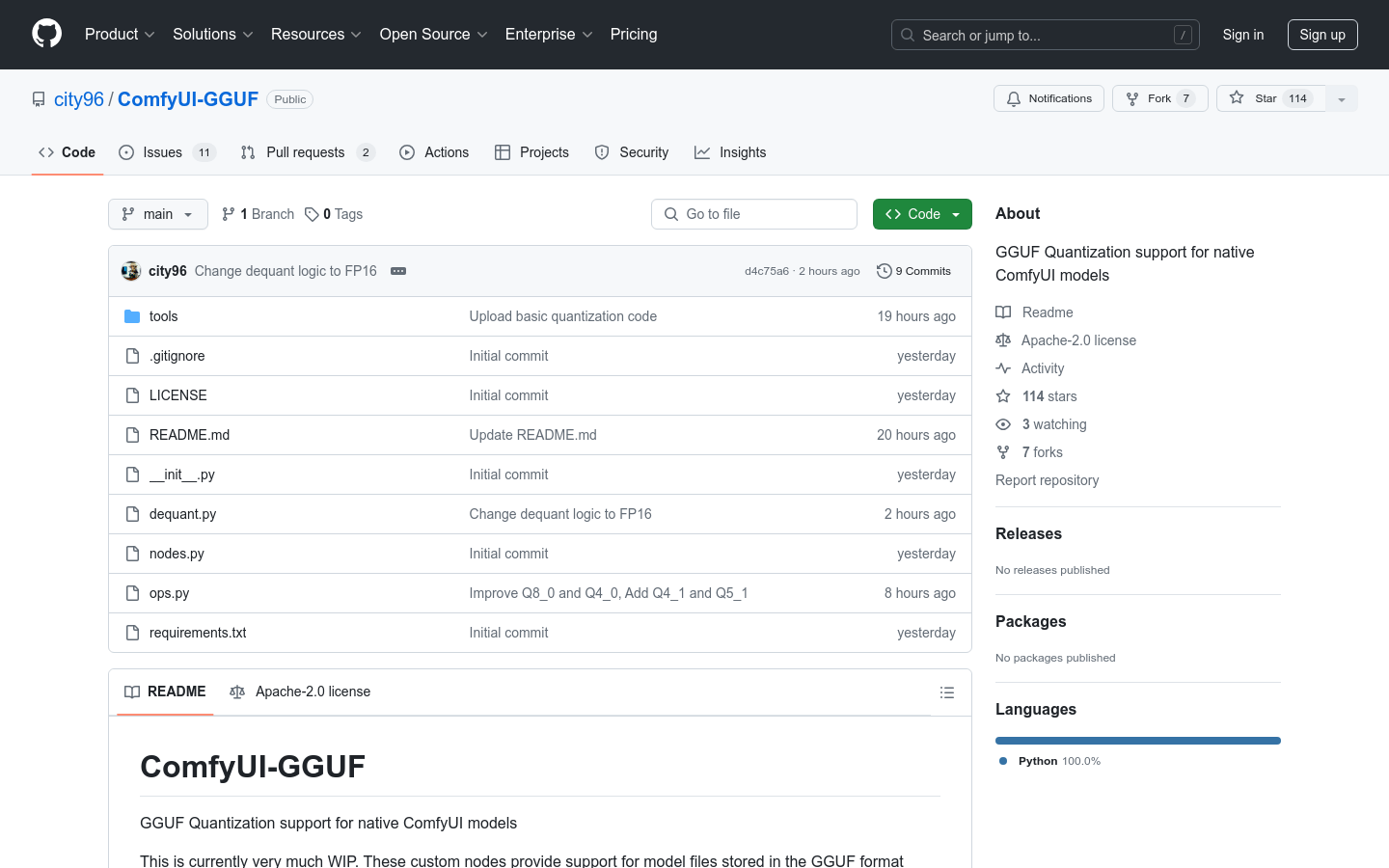

ComfyUI-GGUF

GGUF-Quantisierungsunterstützung zur Optimierung der Leistung nativer ComfyUI-Modelle

Normales ProduktProgrammierungGGUFQuantisierung

ComfyUI-GGUF ist ein Projekt, das native ComfyUI-Modelle mit GGUF-Quantisierung unterstützt. Es ermöglicht die Speicherung von Modelldateien im GGUF-Format, das von llama.cpp verbreitet wird. Obwohl herkömmliche UNET-Modelle (conv2d) nicht für die Quantisierung geeignet sind, scheinen Transformer-/DiT-Modelle wie flux weniger stark von der Quantisierung betroffen zu sein. Dies ermöglicht ihren Betrieb auf Low-End-GPUs mit niedrigeren Bitraten pro Gewichtsvariable.

ComfyUI-GGUF Neueste Verkehrssituation

Monatliche Gesamtbesuche

474564576

Absprungrate

36.20%

Durchschnittliche Seiten pro Besuch

6.1

Durchschnittliche Besuchsdauer

00:06:34