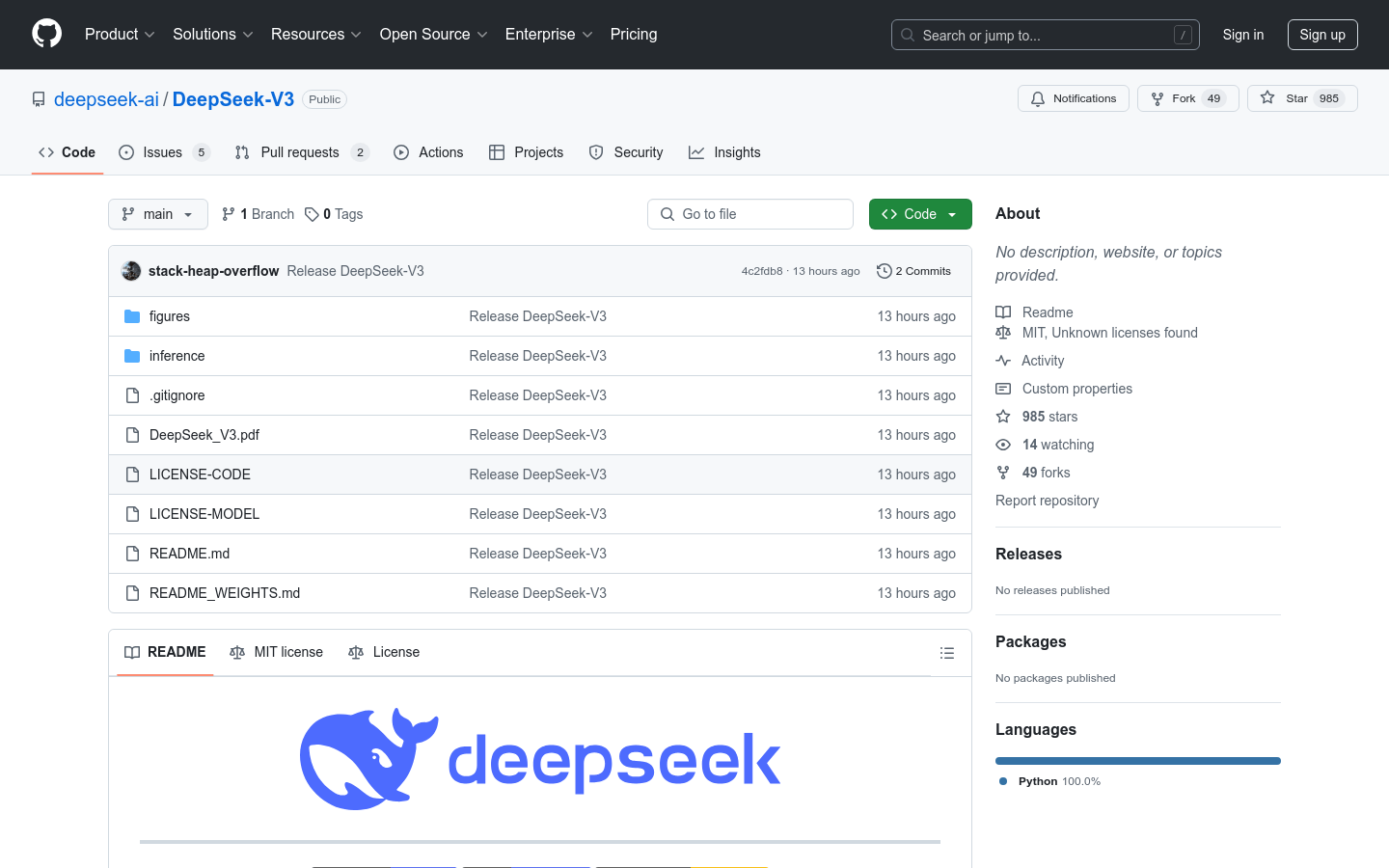

DeepSeek-V3

Ein Mixture-of-Experts Sprachmodell mit 671 Milliarden Parametern.

Inländische AuswahlProduktivitätNatürliche SprachverarbeitungDeep Learning

DeepSeek-V3 ist ein leistungsstarkes Mixture-of-Experts (MoE) Sprachmodell mit insgesamt 671 Milliarden Parametern, von denen bei jeder Aktivierung 37 Milliarden verwendet werden. Es nutzt Multi-head Latent Attention (MLA) und die DeepSeekMoE-Architektur, die sich in DeepSeek-V2 bereits bewährt haben. Darüber hinaus verwendet DeepSeek-V3 erstmalig eine verlustfreie Lastenausgleichsstrategie und ein Multi-Token-Prediction-Trainingsziel für eine verbesserte Leistung. DeepSeek-V3 wurde mit 14,8 Billionen hochwertigen Tokens vortrainiert und anschließend durch überwachtes Feintuning und Reinforcement Learning optimiert. Umfassende Evaluierungen zeigen, dass DeepSeek-V3 andere Open-Source-Modelle übertrifft und eine mit führenden proprietären Modellen vergleichbare Leistung erreicht. Trotz seiner hervorragenden Leistung benötigt DeepSeek-V3 für das vollständige Training lediglich 2.788.000 H800 GPU-Stunden und zeichnet sich durch einen sehr stabilen Trainingsprozess aus.

DeepSeek-V3 Neueste Verkehrssituation

Monatliche Gesamtbesuche

474564576

Absprungrate

36.20%

Durchschnittliche Seiten pro Besuch

6.1

Durchschnittliche Besuchsdauer

00:06:34