Memoria

Implementación de una capa de memoria escalable para ampliar los parámetros del modelo sin aumentar la carga computacional.

Producto ComúnProgramaciónCapa de memoriaAmpliación del modelo

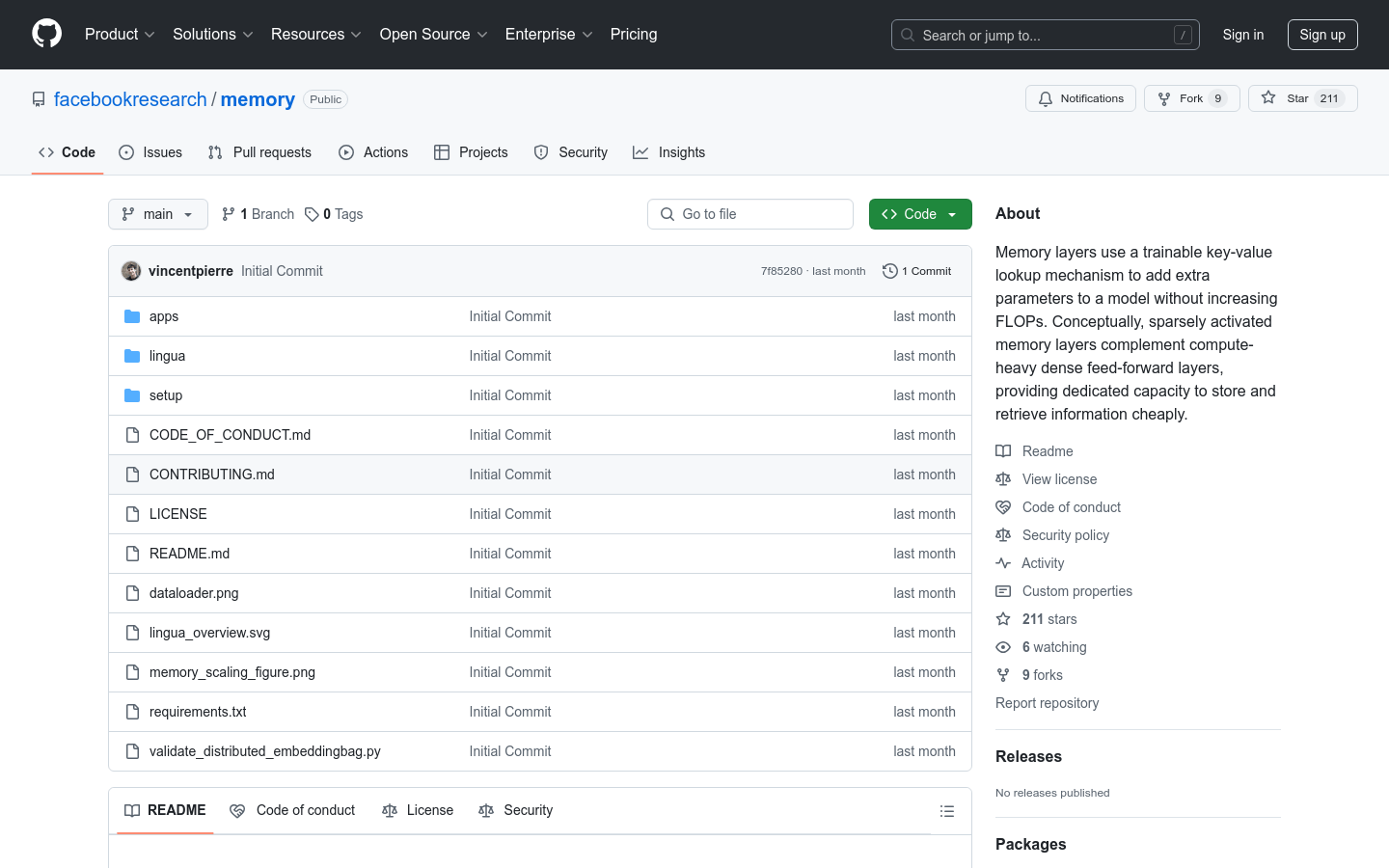

Memory Layers at Scale es una innovadora implementación de capa de memoria que, mediante un mecanismo de búsqueda clave-valor entrenable, añade parámetros adicionales al modelo sin incrementar el número de operaciones de punto flotante. Este método es especialmente importante en los modelos de lenguaje a gran escala, ya que permite mejorar significativamente la capacidad de almacenamiento y recuperación del modelo mientras se mantiene la eficiencia computacional. Las principales ventajas de esta tecnología incluyen la ampliación eficiente de la capacidad del modelo, la reducción del consumo de recursos computacionales y el aumento de la flexibilidad y escalabilidad del modelo. Este proyecto ha sido desarrollado por el equipo de Meta Lingua y es adecuado para escenarios que requieren el procesamiento de datos a gran escala y modelos complejos.

Memoria Situación del tráfico más reciente

Total de visitas mensuales

474564576

Tasa de rebote

36.20%

Páginas promedio por visita

6.1

Duración promedio de la visita

00:06:34