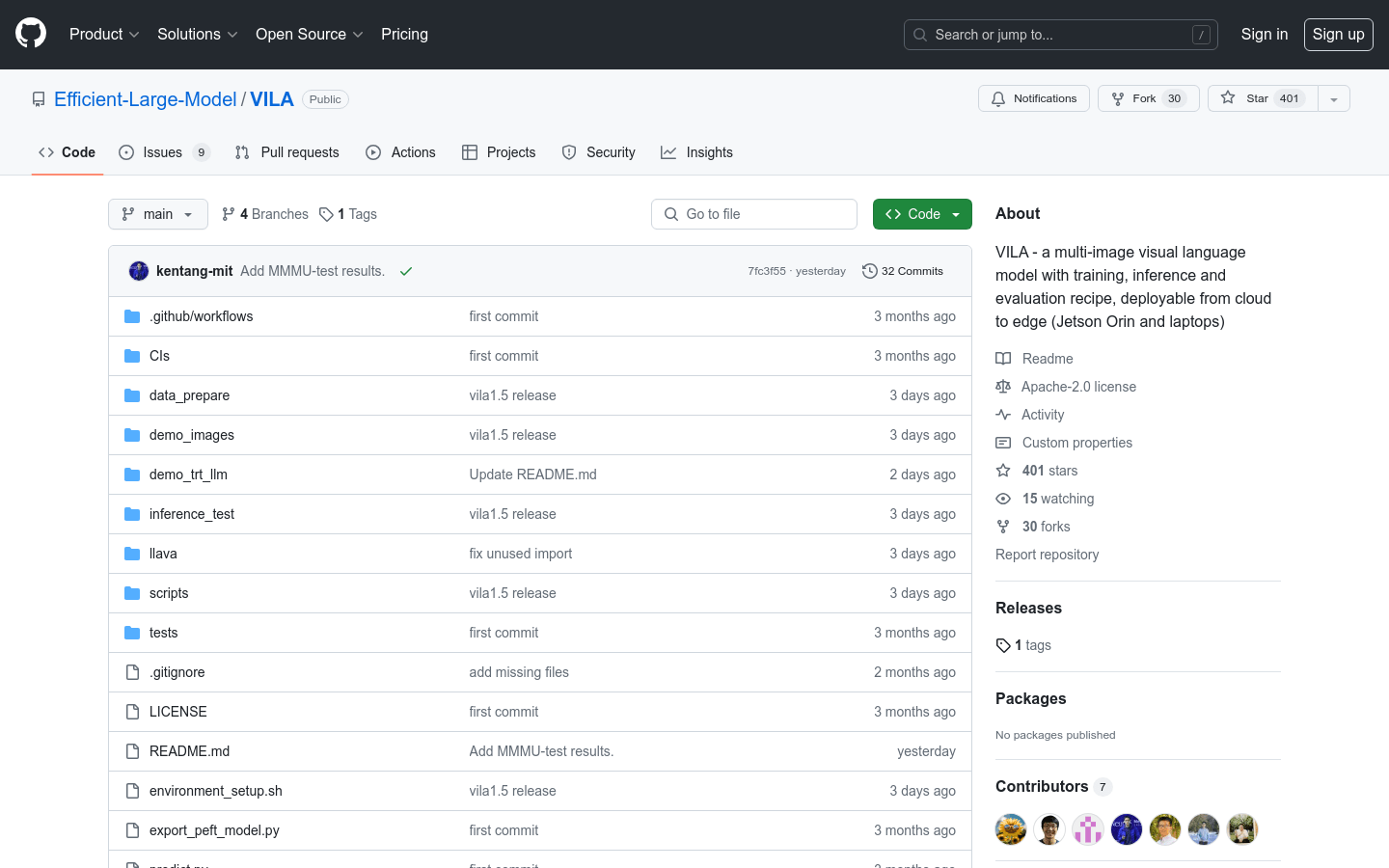

VILA

Modèle de langage visuel multi-image, comprenant des schémas d'entraînement, d'inférence et d'évaluation, déployable du cloud aux périphériques (tels que Jetson Orin et les ordinateurs portables).

Produit OrdinaireImageModèle de langage visuelCompréhension vidéo

VILA est un modèle de langage visuel pré-entraîné (VLM) capable de comprendre la vidéo et les images multiples grâce à un pré-entraînement sur des données image-texte entrelacées à grande échelle. VILA est déployable sur les périphériques grâce à la quantification AWQ 4 bits et au framework TinyChat. Ses principaux atouts sont : 1) les données image-texte entrelacées sont cruciales pour améliorer les performances ; 2) ne pas figer le grand modèle de langage (LLM) pendant le pré-entraînement image-texte entrelacé favorise l'apprentissage contextuel ; 3) le remixage des données d'instructions textuelles est essentiel pour améliorer les performances du VLM et du texte pur ; 4) la compression des jetons permet d'étendre le nombre d'images vidéo. VILA présente des capacités fascinantes, notamment l'inférence vidéo, l'apprentissage contextuel, la chaîne de pensée visuelle et une meilleure connaissance du monde.

VILA Dernière situation du trafic

Nombre total de visites mensuelles

474564576

Taux de rebond

36.20%

Nombre moyen de pages par visite

6.1

Durée moyenne de la visite

00:06:34