OLMoE-1B-7B

Modèle linguistique de grande envergure (LLM) open source et hautement performant

Produit OrdinaireProductivitéModèle linguistique de grande envergureOpen source

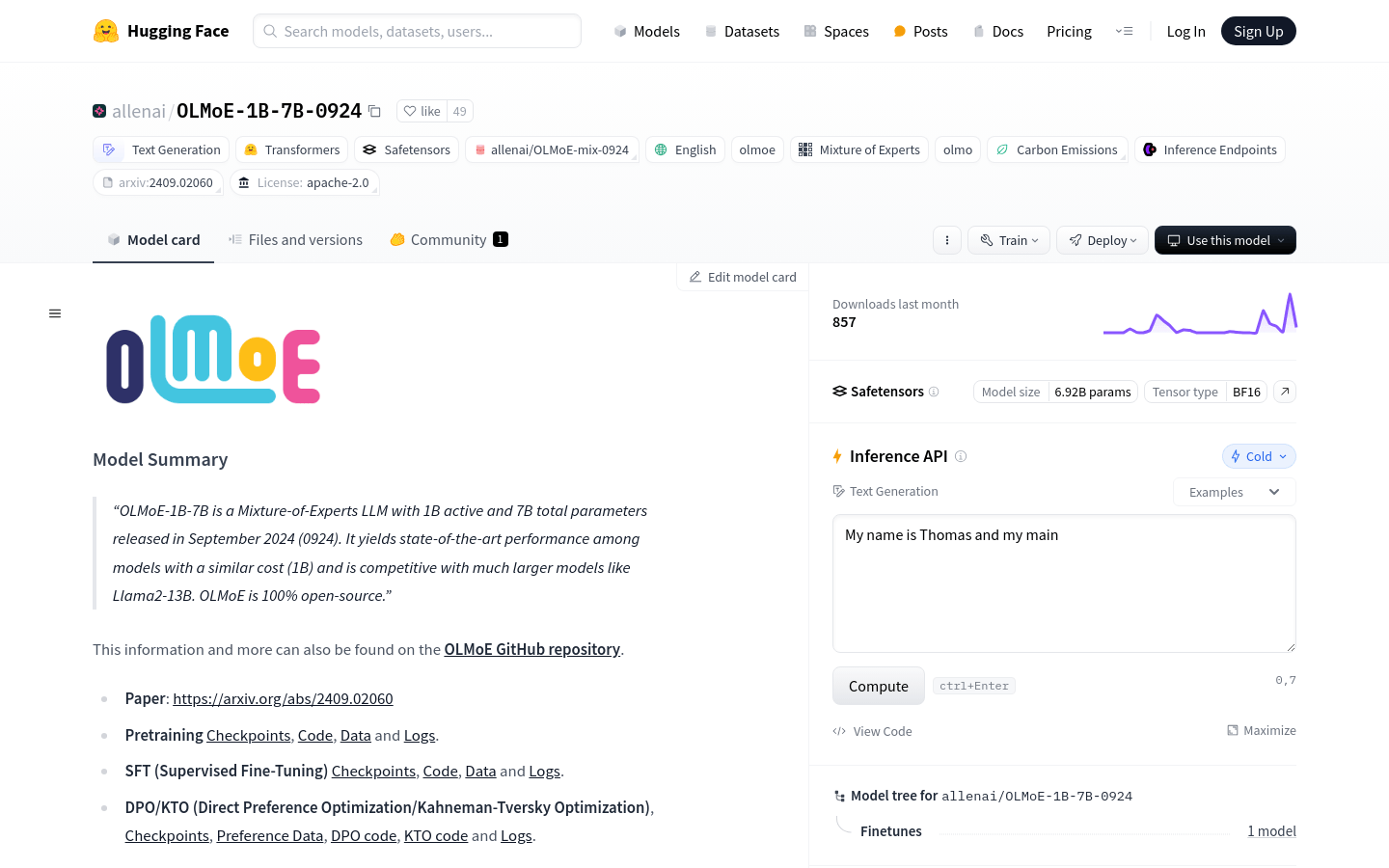

OLMoE-1B-7B est un modèle linguistique de grande envergure (LLM) de type mélange d'experts, doté de 100 millions de paramètres actifs et de 700 millions de paramètres au total. Lancé en septembre 2024, il surpasse les modèles concurrents de coût similaire et rivalise avec des modèles plus grands tels que Llama2-13B. Entièrement open source, OLMoE prend en charge de nombreuses fonctionnalités, notamment la génération de texte, l'entraînement et le déploiement de modèles.

OLMoE-1B-7B Dernière situation du trafic

Nombre total de visites mensuelles

29742941

Taux de rebond

44.20%

Nombre moyen de pages par visite

5.9

Durée moyenne de la visite

00:04:44