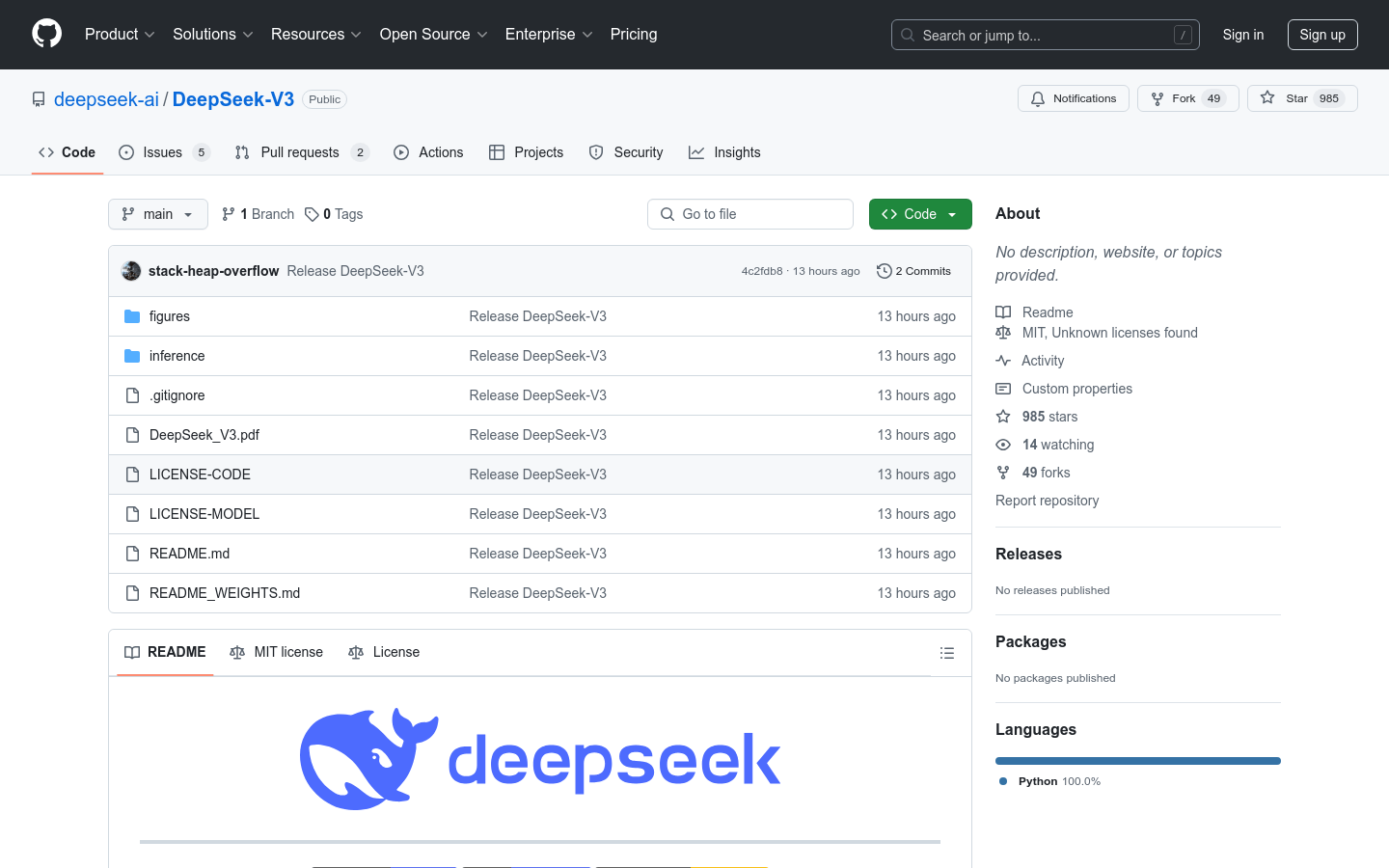

DeepSeek-V3

Modelo de linguagem Mixture-of-Experts com 671B de parâmetros.

Seleção NacionalProdutividadeProcessamento de Linguagem NaturalAprendizado Profundo

DeepSeek-V3 é um poderoso modelo de linguagem Mixture-of-Experts (MoE) com um total de 671 bilhões de parâmetros, ativando 37 bilhões de parâmetros a cada vez. Ele emprega a arquitetura Multi-head Latent Attention (MLA) e DeepSeekMoE, arquiteturas comprovadas no DeepSeek-V2. Além disso, o DeepSeek-V3 apresenta pela primeira vez uma estratégia de balanceamento de carga sem perda auxiliar e um objetivo de treinamento de previsão de múltiplos tokens para desempenho aprimorado. O DeepSeek-V3 foi pré-treinado em 14,8 trilhões de tokens de alta qualidade e, posteriormente, passou por ajustes supervisionados e uma fase de aprendizado por reforço para otimizar seu potencial. Avaliações abrangentes demonstram que o DeepSeek-V3 supera outros modelos de código aberto e alcança desempenho comparável aos principais modelos proprietários. Apesar do desempenho excepcional, o treinamento completo do DeepSeek-V3 requer apenas 2,788 milhões de horas de GPU H800, com um processo de treinamento estável.

DeepSeek-V3 Situação do Tráfego Mais Recente

Total de Visitas Mensais

474564576

Taxa de Rejeição

36.20%

Média de Páginas por Visita

6.1

Duração Média da Visita

00:06:34