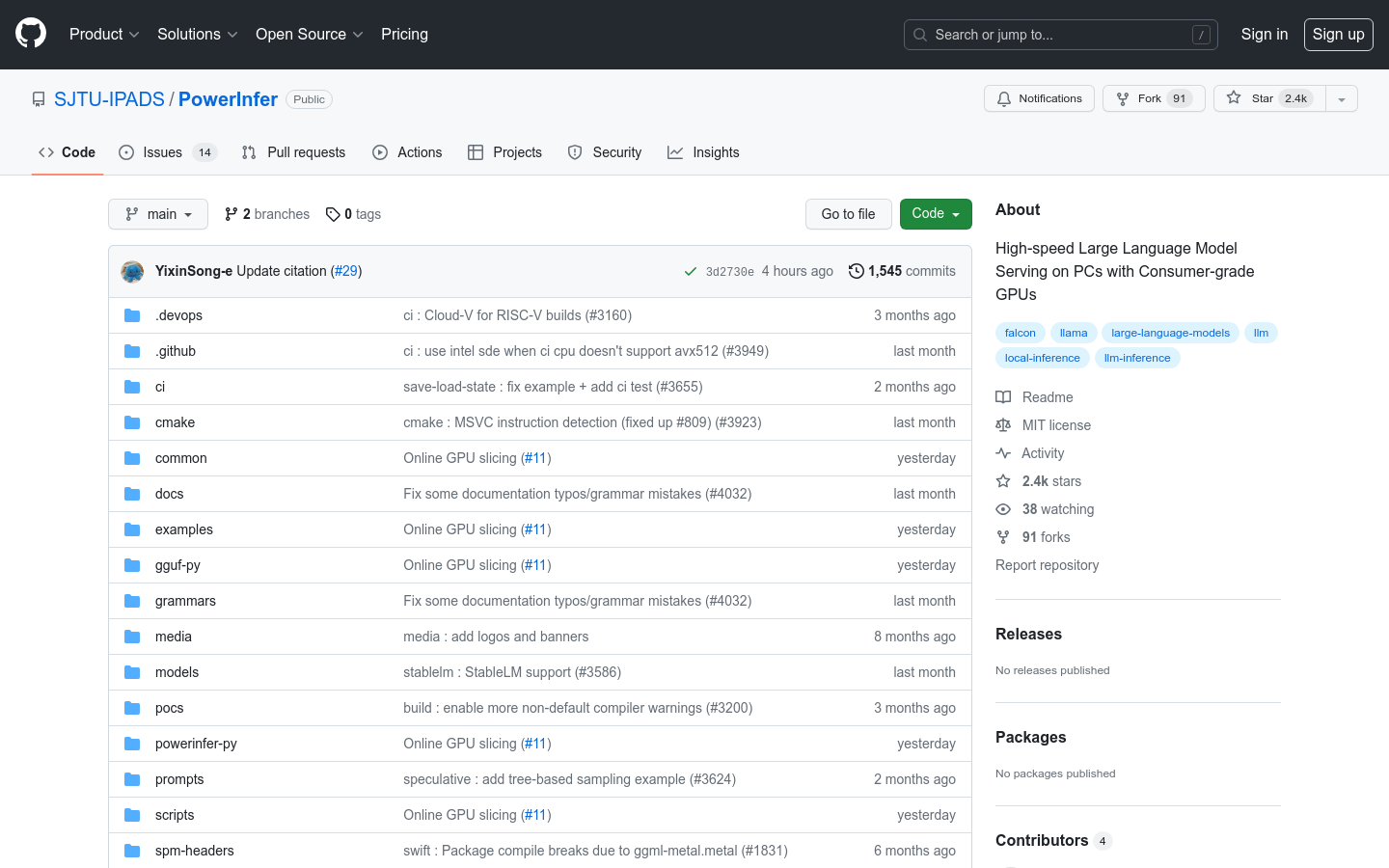

PowerInfer

Hochgeschwindigkeits-Inferenz-Engine für große Sprachmodelle zur lokalen Bereitstellung

Normales ProduktProduktivitätSprachmodellInferenz-Engine

PowerInfer ist eine Engine, die auf PCs mit Consumer-GPUs die Hochgeschwindigkeits-Inferenz großer Sprachmodelle ermöglicht. Durch die Ausnutzung der hohen Lokalität bei der LLM-Inferenz und das Vorladen von aktivierten Neuronen auf die GPU reduziert sie den GPU-Speicherbedarf und den Datentransfer zwischen CPU und GPU deutlich. PowerInfer integriert außerdem einen adaptiven Prädiktor und neuronal-sensitive Sparse-Operatoren, um die Effizienz der neuronalen Aktivierung und der Berechnungssparsität zu optimieren. Auf einer einzelnen NVIDIA RTX 4090 GPU erreicht es eine Inferenzgeschwindigkeit von durchschnittlich 13,20 Token pro Sekunde, nur 18 % langsamer als die Spitzenserver-GPU A100. Dabei bleibt die Modellgenauigkeit erhalten.

PowerInfer Neueste Verkehrssituation

Monatliche Gesamtbesuche

474564576

Absprungrate

36.20%

Durchschnittliche Seiten pro Besuch

6.1

Durchschnittliche Besuchsdauer

00:06:34