Gemma-2B-10M

Gemma 2B-Modell, unterstützt Sequenzen mit einer Länge von 10 Millionen Tokens und optimiert die Speichernutzung. Ideal für Anwendungen mit großen Sprachmodellen.

Normales ProduktProgrammierungSprachmodellAufmerksamkeitsmechanismus

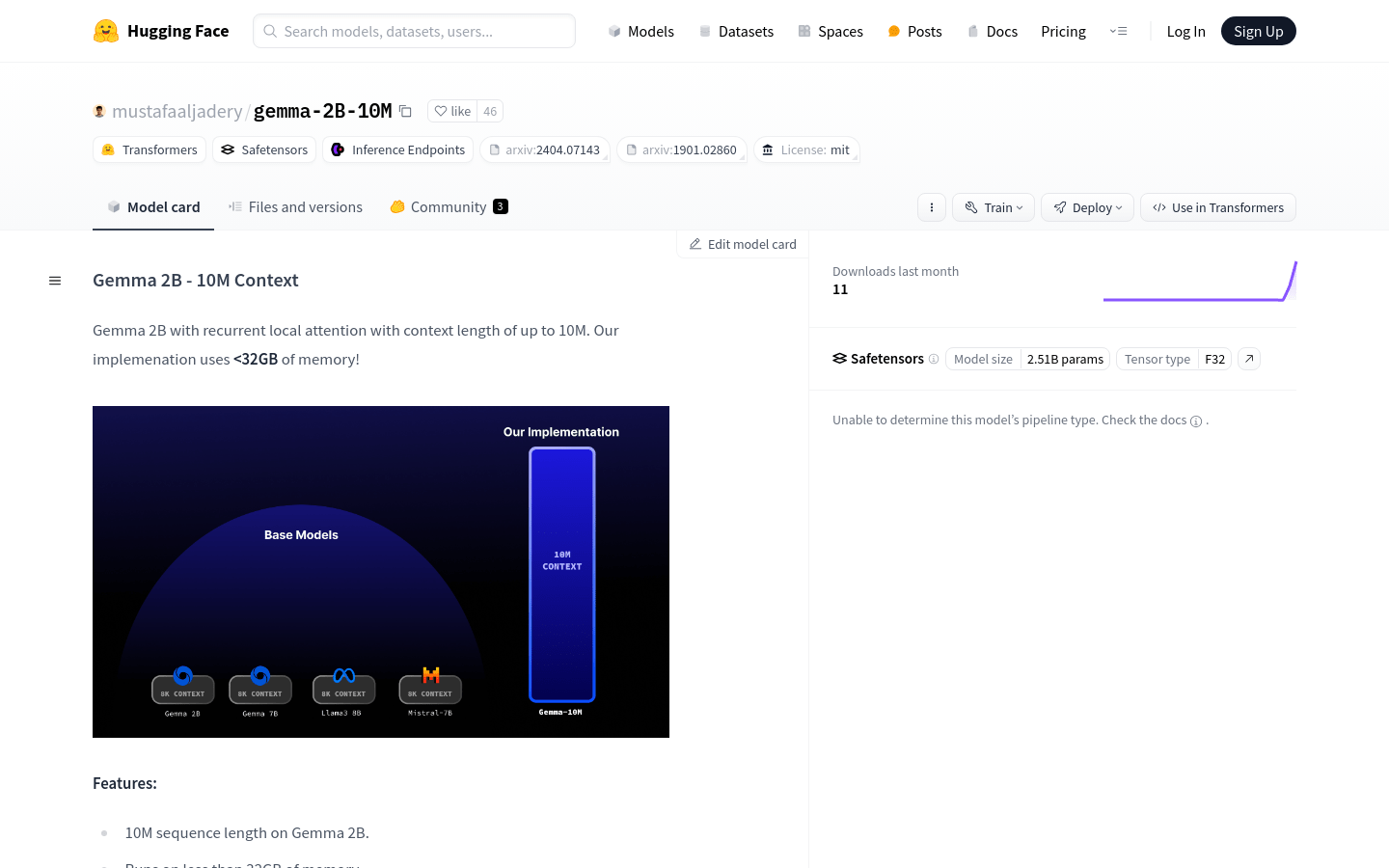

Gemma 2B - 10M Context ist ein großes Sprachmodell, das durch innovative Optimierungen des Aufmerksamkeitsmechanismus Sequenzen mit einer Länge von bis zu 10 Millionen Tokens bei einem Speicherverbrauch von unter 32 GB verarbeiten kann. Das Modell nutzt die Technik der rekursiven lokalen Aufmerksamkeit, inspiriert von der Transformer-XL-Arbeit, und ist ein leistungsstarkes Werkzeug für die Verarbeitung umfangreicher Sprachdaten.

Gemma-2B-10M Neueste Verkehrssituation

Monatliche Gesamtbesuche

29742941

Absprungrate

44.20%

Durchschnittliche Seiten pro Besuch

5.9

Durchschnittliche Besuchsdauer

00:04:44