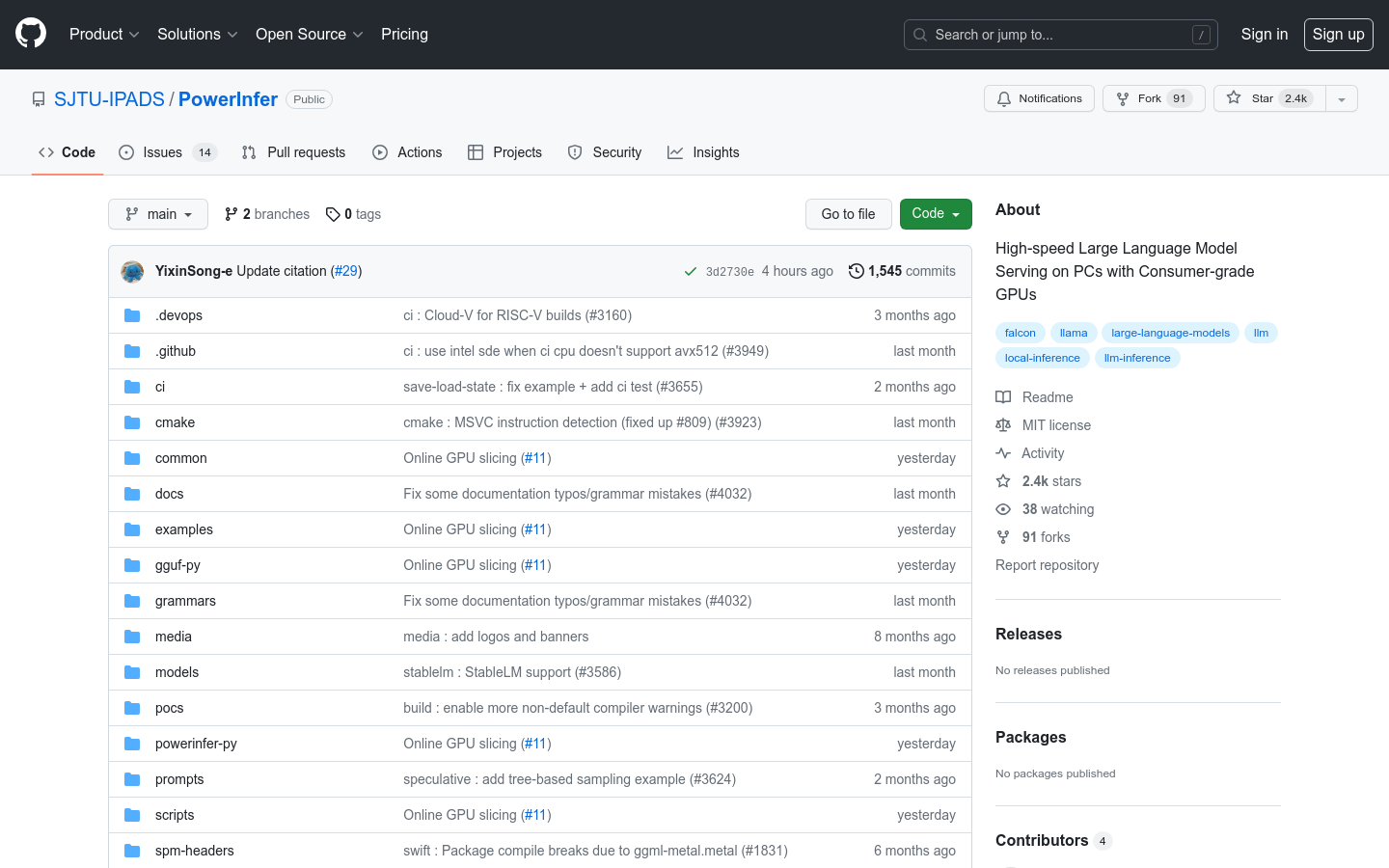

PowerInfer

高速大規模言語モデルのローカル展開推論エンジン

一般製品生産性言語モデル推論エンジン

PowerInferは、コンシューマ向けGPUを利用して、パーソナルコンピュータ上で高速に大規模言語モデルの推論を行うエンジンです。LLM推論における高い局所性の特徴を利用し、事前に活性化されたニューロンをGPUにプリロードすることで、GPUメモリ要求とCPU-GPU間のデータ転送を大幅に削減します。PowerInferは、適応型予測器とニューロン感知型スパース演算子を統合し、ニューロンの活性化と計算スパース性の効率を最適化します。単一のNVIDIA RTX 4090 GPU上で、平均毎秒13.20トークンの生成速度で推論を実行でき、最上位サーバー級A100 GPUと比較してわずか18%の差しかありません。同時に、モデルの精度は維持されます。

PowerInfer 最新のトラフィック状況

月間総訪問数

474564576

直帰率

36.20%

平均ページ/訪問

6.1

平均訪問時間

00:06:34