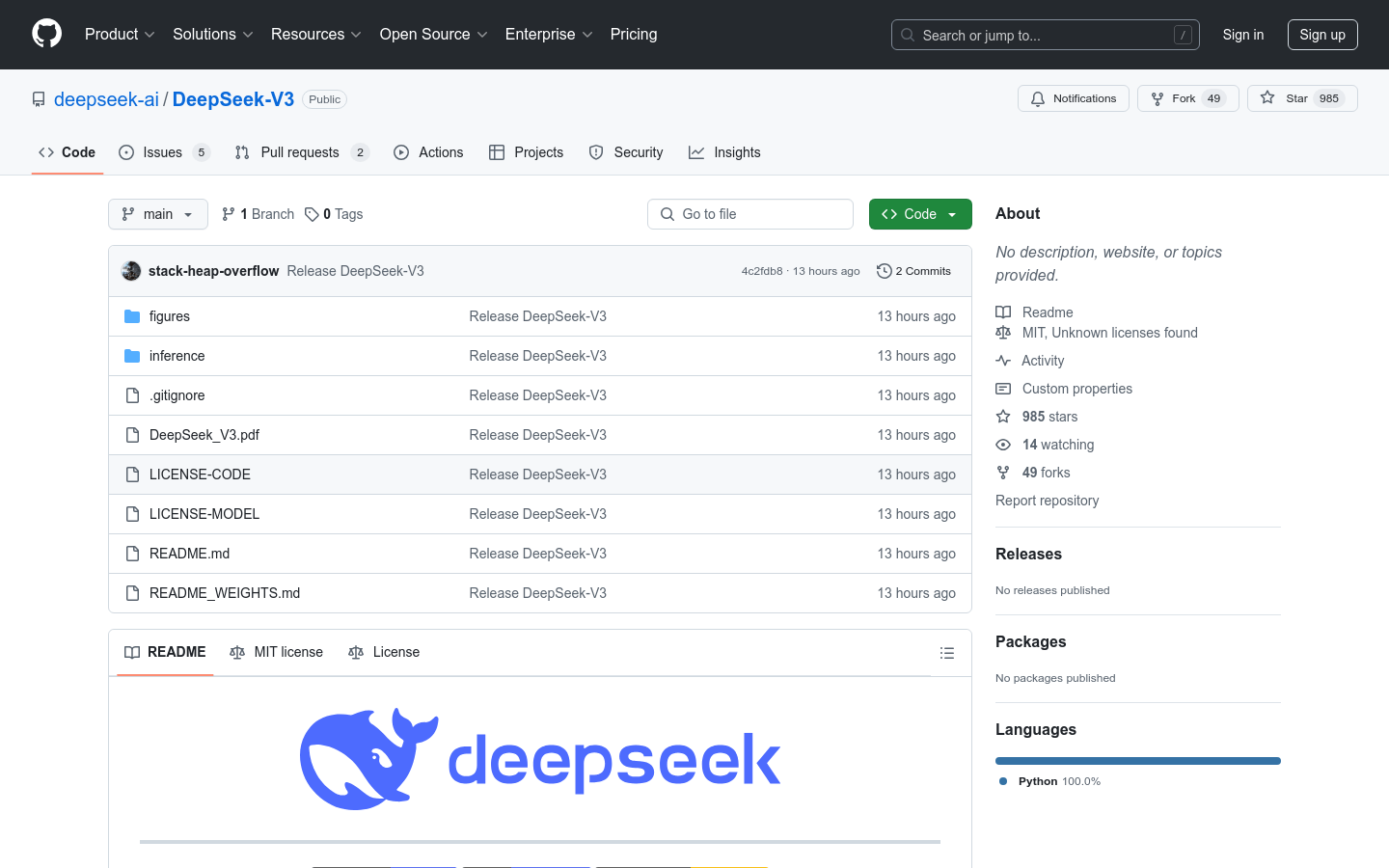

DeepSeek-V3

Un modelo de lenguaje Mixture-of-Experts con 671B parámetros.

Selección NacionalProductividadProcesamiento del Lenguaje NaturalAprendizaje Profundo

DeepSeek-V3 es un potente modelo de lenguaje Mixture-of-Experts (MoE) con un total de 671B parámetros, activando 37B parámetros por cada solicitud. Emplea la arquitectura Multi-head Latent Attention (MLA) y DeepSeekMoE, probadas con éxito en DeepSeek-V2. Además, DeepSeek-V3 implementa por primera vez una estrategia de balanceo de carga sin pérdida auxiliar y un objetivo de entrenamiento de predicción de múltiples tokens para lograr un rendimiento superior. DeepSeek-V3 se preentrenó en 14,8 billones de tokens de alta calidad, seguido de un ajuste fino supervisado y una fase de aprendizaje por refuerzo para aprovechar al máximo sus capacidades. Las evaluaciones integrales muestran que DeepSeek-V3 supera a otros modelos de código abierto y alcanza un rendimiento comparable al de los modelos propietarios líderes. A pesar de su excelente rendimiento, el entrenamiento completo de DeepSeek-V3 solo requirió 2.788M de horas de GPU H800, y el proceso de entrenamiento fue muy estable.

DeepSeek-V3 Situación del tráfico más reciente

Total de visitas mensuales

474564576

Tasa de rebote

36.20%

Páginas promedio por visita

6.1

Duración promedio de la visita

00:06:34