OLMoE-1B-7B

Modelo de linguagem grande (LLM) eficiente e de código aberto

Produto ComumProdutividadeModelo de linguagem grandeCódigo aberto

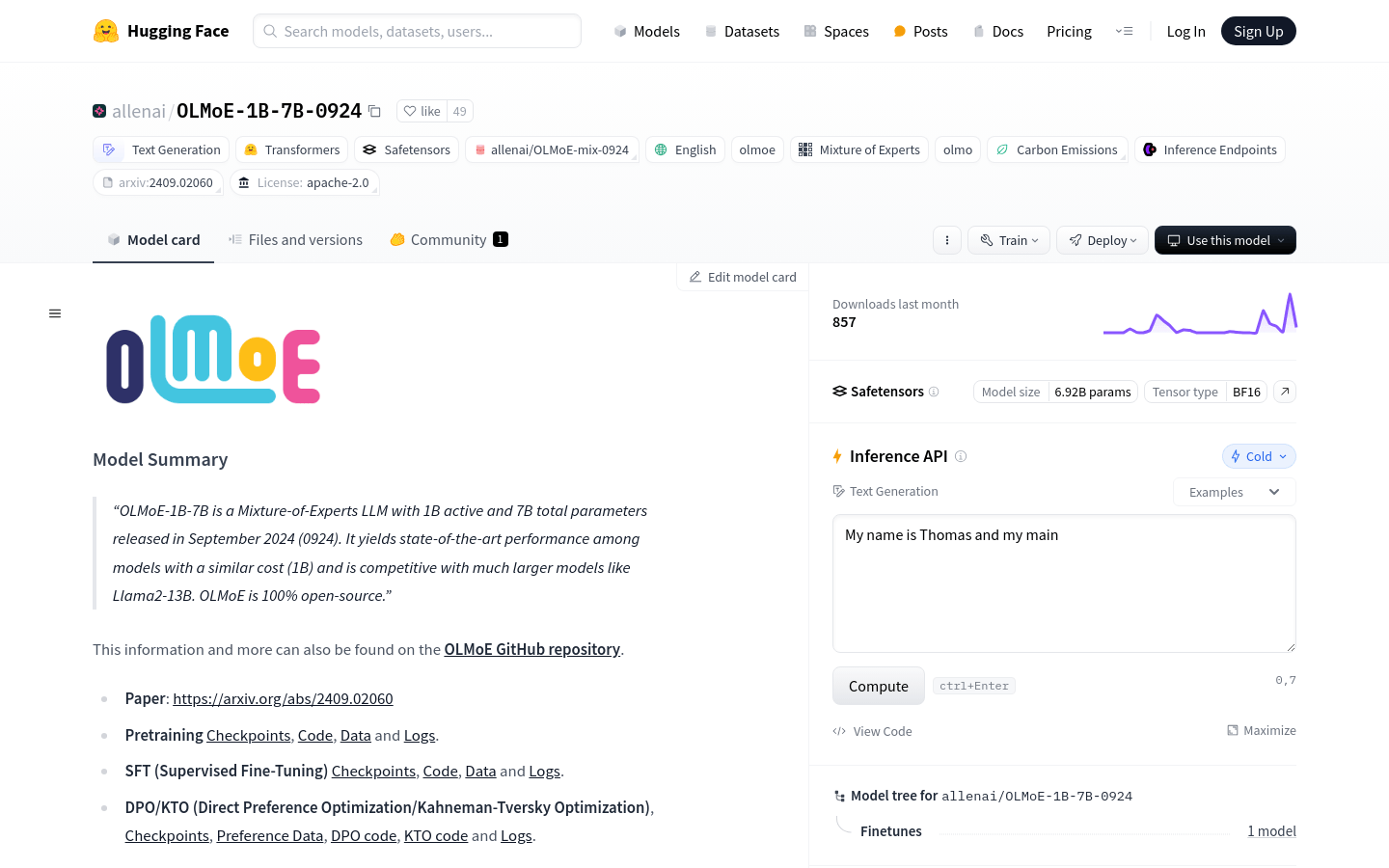

OLMoE-1B-7B é um modelo de linguagem grande (LLM) misto de especialistas com 100 milhões de parâmetros ativos e 700 milhões de parâmetros totais, lançado em setembro de 2024. Este modelo demonstra desempenho excepcional em comparação com modelos de custo similar, competindo com modelos maiores como o Llama2-13B. O OLMoE é totalmente de código aberto e suporta diversas funcionalidades, incluindo geração de texto, treinamento e implantação de modelos.

OLMoE-1B-7B Situação do Tráfego Mais Recente

Total de Visitas Mensais

29742941

Taxa de Rejeição

44.20%

Média de Páginas por Visita

5.9

Duração Média da Visita

00:04:44