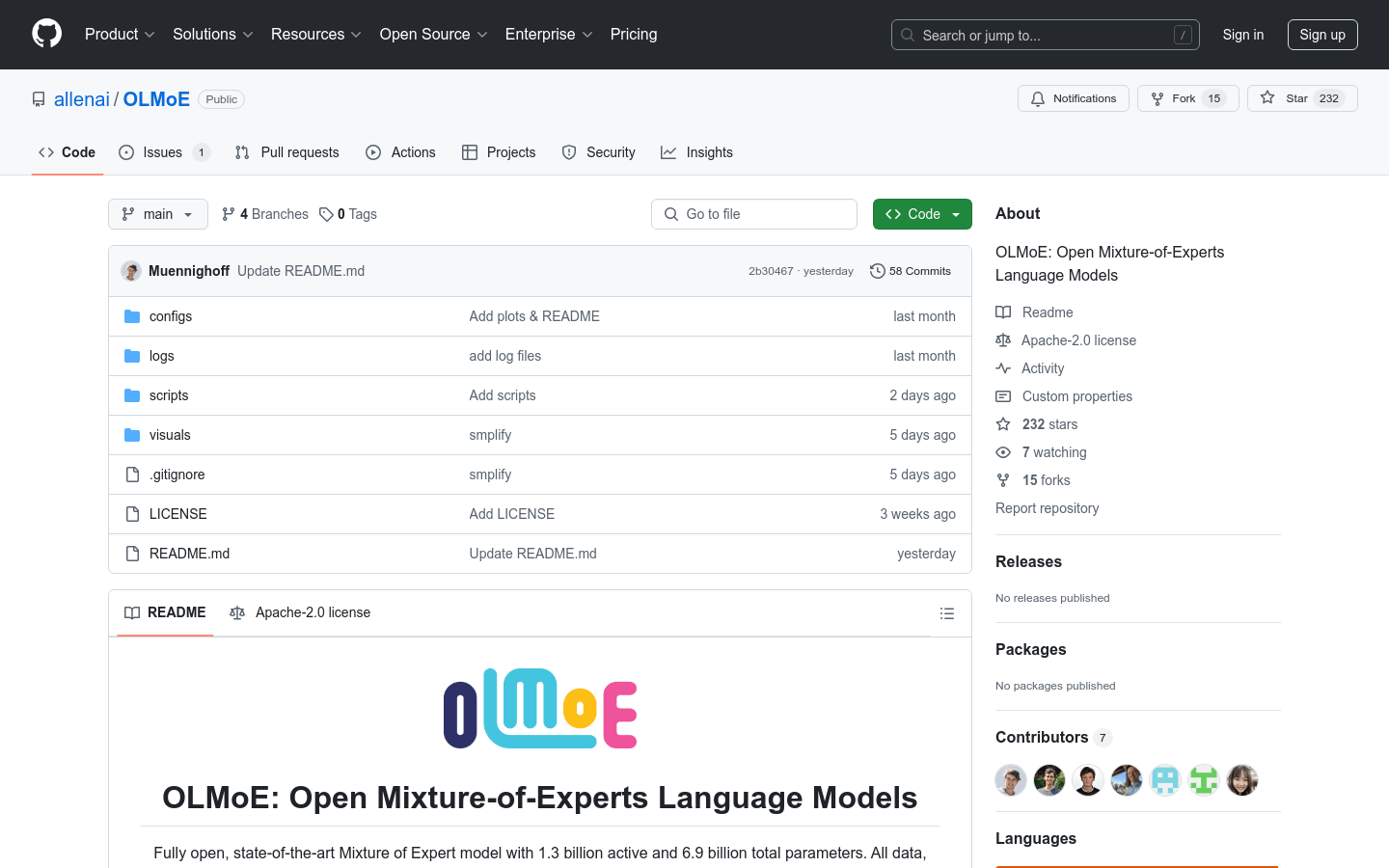

OLMoE

Modelo de linguagem de mistura de especialistas de código aberto com 130 milhões de parâmetros ativos.

Produto ComumProdutividadeProcessamento de Linguagem NaturalModelo de Mistura de Especialistas

O OLMoE é um modelo de mistura de especialistas de ponta, totalmente aberto, com 130 milhões de parâmetros ativos e 690 milhões de parâmetros totais. Todos os dados, códigos e logs do modelo foram publicados. Ele fornece uma visão geral de todos os recursos do artigo 'OLMoE: Open Mixture-of-Experts Language Models'. O modelo tem aplicações importantes em pré-treinamento, ajuste fino, adaptação e avaliação, representando um marco no campo do processamento de linguagem natural.

OLMoE Situação do Tráfego Mais Recente

Total de Visitas Mensais

474564576

Taxa de Rejeição

36.20%

Média de Páginas por Visita

6.1

Duração Média da Visita

00:06:34